Peter Krah

01809 Heidenau/Sa.

Anmerkungen zum 4. Bericht des IPCC 2007

Computermodellierung und -simulation

Vorbemerkung:

Der 4. Bericht des IPCC 2007 (IPCC AR4) ist ein sehr umfangreiches Werk (ca. 2400 Seiten). Die hier vorgenommenen Anmerkungen befassen sich mit speziellen Aussagen des Berichts. Das Augenmerk wurde vorrangig auf die Computermodellierung und -simulation gerichtet, wie sie im Band 1 The Physical Science Basis des Berichtes beschrieben werden. Die Fokussierung erklärt sich dadurch, dass wegen einer jahrzehntelangen Tätigkeit als Systemanalytiker und Manager in der Softwareentwicklung die persönliche Kompetenz für eine derartige Untersuchung am ehesten gegeben ist. Auf der Grundlage der im Berichtsband verstreut vorhandenen Aussagen, gezielter Auswertung der Referenzliteratur sowie eigener Kenntnisse wird das Vorgehen bei der Modellierung und Simulation referiert und somit ein Bild zu dem Teil des Berichtes gegeben, der die quantitativen Aussagen festlegt.

Modellierung und Simulation im Bericht

Modellierung und Simulation werden vorrangig im Kapitel 8 des o.g. Band 1 behandelt. Der Bericht beschreibt die zum Einsatz kommenden IT-Technologien und -Verfahren nicht explizit. Die Informationstechnik

(IT) wird als Werkzeug betrachtet, mit dem die Klimaereignisse (Temperatur, Wolken, Meereis, Einfluss der Treibhausgase usw.) modelliert, die Modellkomponenten zu einem System zusammen geschaltet und anschließend die Ereignisse simuliert werden. Klimasimulationen werden durch Variation von Anfangs- und Randbedingungen der zugrunde liegenden Algorithmen erzeugt.

Modellierung und Simulation sind aus der Sicht der Klimaereignisse beschrieben. Welche Algorithmen für die Modellierung und Simulation zugrunde liegen, wird im Bericht nicht ausgeführt. Folgerichtig

gibt es so gut wie keine Angaben zur informationstechnischen Umsetzung. Dies erschwert das Verständnis, ist aber legitim hinsichtlich der Zielstellung des Berichtes.

Das Klimageschehen wird allgemein durch die Navier-Stokes-Gleichungen1 beschrieben. Die Navier-Stokes-Gleichungen bilden ein System von nichtlinearen

partiellen Differentialgleichungen 2. Ordnung. Es ist bis heute nicht gelungen, die Existenz von allgemeinen Lösungen nachzuweisen. Die Differentialgleichungen werden mittels finiter Elemente oder Differenzenmethoden

diskretiert und einer numerischen Behandlung zugänglich gemacht. Für die Klimamodelle ist dieser Weg beschritten worden, Klimaereignisse werden durch entsprechende Algorithmen, die weitgehend nichtlinear sind, im

Computer abgebildet2. Dieses Vorgehen kann als fundamentales Charakteristikum der aktuellen Klimamodelle bezeichnet werden.

Bei der Modellierung wird die Erdoberfläche mit einem Netz überzogen, dessen Maschen die Längen- und Breitenbegrenzungen so genannter Gridelemente sind. Ein Gridelement ist das Basiselement

eines jeden Klimamodells, neben Länge und Breite weist es gewöhnlich auch eine Höhe (Tiefe) auf. Die Höhe (Tiefe) wird in Schichten (layer) unterteilt. Land-Gridelemente und Meeres-Gridelemente unterscheiden sich im Allgemeinen in der Größe (letztere sind kleiner). Die Größe eines Gridelements bestimmt u.a.

die geografische Auflösung der Simulation3.

Parallel dazu werden die Differenzengleichungen, die für die einzelnen Klimaereignisse stehen, mittels Programmierung in eine für den Computer abarbeitbare Form (Modellkomponente) überführt.

Eine Modellkomponente ist in der Regel durch Eingabe von Daten (Parametrisierung) steuerbar. Durch Parametervorgaben werden Zeithorizonte und die Schrittweiten dahin festgelegt, Anfangs- und Randbedingungen variiert oder auch die Abarbeitung verändert.

In einem weiteren Schritt werden dem Gridelement entsprechend seiner geografischen Position (Land oder Meer) die Modellkomponenten zugeordnet, welche die dort vorkommenden Klimaereignisse abbilden.

Bei der Abarbeitung erhält ein Gridelement Eingangswerte aus einem Arbeitsspeicher. Die Eingangswerte werden gemäß der zugeordneten Modellkomponenten und etwaiger Parametervorgaben verändert

und als Ausgangswerte in den Arbeitsspeicher abgelegt. Eine alle Gridelemente umfassende Steuerung besorgt die Initialvorgabe der Eingangswerte und überwacht und lenkt die Abarbeitung. An deren Schluss werden die Ergebnisse der einzelnen Gridelemente wie Temperatur, Niederschlag usw. aus dem Arbeitsspeicher ausgelesen und weiterbearbeitet.

Die Entwicklung der Klimamodelle begann vor nunmehr 30 Jahren. Der Fortschritt in der Informationstechnik bewirkte, dass sowohl die Anzahl der modellierten Klimaereignisse zunahm als auch die geografische

Auflösung immer feiner wurde. Aktuell werden drei Typen von Klimamodellen unterschieden4:

1. die Allgemeinen Atmosphäre-Ozean-Zirkulationsmodelle – (Atmosphere-Ocean General Circulation Model – AOGCM ):

Die AOGCM sind die umfassendsten Klimamodelle, sie enthalten eine wachsende Zahl von Komponenten, welche einzelne Klimaereignisse örtlich und zeitlich in den Computer abbilden. AOGCM bestehen aus den

Teilsystemen für die Atmosphäre (AGCM) und für den Ozean (OGCM), sie können in den meisten Fällen auch unabhängig voneinander arbeiten. Das Koppeln beider Teilsysteme ist nicht trivial, die Modellgüte

wird u.a. dadurch bestimmt, dass keine externen Eingriffe (flux adjustment)5 erforderlich werden, um den Übergang zwischen den Teilsystemen numerisch stabil zu halten. Die geografische Auflösung, die Layerzahl sowie die Anzahl der Zeitschritte führen zu enormen Anforderungen an die Computerressourcen. Die Schrittweite kann von wenigen

Minuten bis zu einem Jahr differieren, der Zeithorizont liegt dann bei einigen Jahren bis zu mehreren zehntausend Jahren. AOGCM werden auf Supercomputern oder Multiprozessor-Rechnern betrieben.

Der 4. IPCC-Bericht nennt 23 AOGCM, die ihm zugearbeitet haben. Beispielhaft für die anderen seien die Daten von CSIRO-MK3.0 von der Commonwealth Scientific and Industrial Research Organisation, Atmospheric

Research aus Australien angegeben. Die Gridelementgröße für die Atmosphäre beträgt ca. 1.9° x 1.9°, die Anzahl der Layer ist 18 bei einer maximalen Höhe von 4,5 hPa (ca. 36.000 m). Für den Ozean betragen die Werte 0.8° x 1.9° bei 31 Layer und einer Tiefe von 4800 Meter.

2. Die einfachen Klimamodelle – (simple climate model)6:

Mit einem einfachen Klimamodell werden in einem parametrisierten Vorgehen

− die Emissionen von Treibhausgasen zeitlich vorgegeben,

− die Strahlungsantriebe entsprechend dieser Emissionen simuliert,

− die durchschnittliche globale Oberflächentemperatur daraus bestimmt,

− der Anstieg der Meeresoberfläche und die Auswirkungen auf Gletscher und Eisschilde prognostiziert sowie

− regional begrenzte abrupte Klimaänderungen simuliert.

Die einfachen Klimamodelle setzen auf den Vorgaben und Ergebnissen von 19 der im 4. IPCC-Bericht aufgeführten AOGCM auf. Das einfache Klimamodell wird in einem iterativen Prozess den von dem zugehörigen

AOGCM gelieferten Zeitserien zur Temperatur und dem berechneten ozeanischen Wärmeaufnahmevermögen angeglichen. Der Einsatz eines einfachen Klimamodells spart Computeraufwand. Es lassen sich mit einem auf die hier interessanten Klimaereignisse (Treibhausgase) abgerüsteten Modell viel leichter als mit einem AOGCM eine große Anzahl von Varianten durchrechnen.

3. Erdsystemmodelle mittlerer Komplexität (Earth System Models of Intermediate Complexity – EMIC)7:

Die Erdsystemmodelle mittlerer Komplexität liegen mit ihrer Funktionalität zwischen den AOGCM und den einfachen Klimamodellen. Ein EMIC besteht aus einem vereinfachten AGCM, das mit einem OGCM gekoppelt

ist oder aus Modellkomponenten für Atmosphäre und Ozean, die vereinfachte Algorithmen im Vergleich zu den AOGCM nutzen. EMIC sind von sehr unterschiedlicher Ausprägung, einige nähern sich in ihrer Funktionalität

den AOGCM, andere wurden wie die einfachen Klimamodelle für die Berechnung des Treibhausgas-Einflusses geschaffen.

Ein EMIC ist in der Regel so ausgelegt, dass es auf einem leistungsfähigen PC oder einer Workstation lauffähig ist. Ein wichtiges Einsatzgebiet der EMIC ist die Langzeituntersuchung von Klimaänderungen.

Ein Maß ihrer Leistungsfähigkeit ist deshalb die Anzahl von Jahren, die vom EMIC in einem Computerlauf von vorgegebener Dauer als Klimaablauf simuliert werden kann. Die Werte schwanken stark, von 20.000 Jahre/CPU-Std. bis zu 36 CPU-Std. für 100 Jahre8.

Evaluierung und Tuning der Modelle

Ein Klimamodell ist ein sehr komplexes System mit vielen Komponenten. Seiner Nutzung gehen viele Tests voraus, die sowohl die Einzelkomponenten als auch das Gesamtsystem umfassen.

Für Komponententests stehen standardisierte Verfahren zur Verfügung, welche die angewandten numerischen Methoden und die physikalische Parametrisierung verifizieren. Der Systemtest speziell von

AOGCM wird durch das Programm für Klimamodell-Diagnose und –Vergleich (Program for Climate Model Diagnosis and Intercomparison – PCMDI)9 unterstützt. Programmziel ist, die Qualität der Simulationen zu erhöhen. Dazu werden Methoden und Werkzeuge entwickelt, die das Verhalten der Modelle analysieren und vergleichen. Aktuell liegt der Schwerpunkt der Arbeit auf dem Bereitstellen eines verbindlichen Testspiegels (Testbed) für die Modell-Parametrisierung, um damit den Vergleich zwischen den einzelnen Klimamodellen zu standardisieren.

Die im Bericht vorgestellten Modelle simulieren das Klima gemäß den vorgegebenen Algorithmen und Randbedingungen. Die Güte der Modellergebnisse hat sich zuvorderst an der Realität zu

messen, also an den existierenden Messdaten zum Klima. Diese Daten liegen jedoch im qualitativ und quantitativ ausreichenden Maße erst seit wenigen Jahrzehnten vor, zu wenig, um belastbare Vorausberechnungen für

die ins Auge gefasste Zeitdauer (≥ 100 Jahre) zu erhalten. Dazu ist mindestens ein weiterer Fixpunkt für die Modelljustierung erforderlich. Dieser wird mit dem Höhepunkt der letzten Eiszeit festgelegt10.

Ein weiterer Vergleich kann mit Modellen für die Wettervorhersage geführt werden. Klimamodelle schneiden hierbei in der Regel schlechter ab. Die Ursache wird in der zu geringen Auflösung (zu großen Gridelementgröße) gesehen.

Beim so genannten Modelltuning wird wie folgt vorgegangen: Durch Variation von Parametern wird eine große Anzahl von Ergebnisvarianten erzeugt (im vorliegenden Fall ca. eintausend). Im nächsten

Schritt werden die Varianten mit Messdaten und daraus abgeleiteten berechneten Daten und Schätzungen verglichen und alle die aussortiert, die das Klima nicht hinreichend gut wiedergeben. Gleiches geschieht mit der Simulation des Höhepunktes der letzten Eiszeit. Übrig bleiben schließlich ca. 10 % der ursprünglichen Varianten, deren Parameter als zulässig für eine Modellrechnung betrachtet werden11.

Klimasensitivität

Die Klimasensitivität ist die Größe, welche die Auswirkung eines vorgegebenen Strahlungsantriebs (radiative forcing) auf das globale Klimasystem wiedergibt. Im 4. IPCC-Bericht wird sie als die Änderung der durchschnittlichen globalen Oberflächentemperatur definiert, die sich nach einer

Verdoppelung der atmosphärischen CO2-Konzentration einstellt. Diese Definition ist übrigens seit dem Beginn der aktuellen Klimadiskussion gültig, auch die vom IPCC und seinen Vorgängerorganisationen

veröffentlichten Temperaturwerte (1,5 – 4,5 ºC) für eine CO2-Verdopplung haben sich seit den siebziger Jahren so gut wie nicht geändert.

Die Vorgabe zur Bestimmung der Klimasensitivität besteht aus einer 1%igen Steigerung der CO2-Konzentration/Jahr bis zum Erreichen des doppelten Ausgangswertes (2xCO2). Anschließend

wird die Konzentration nicht weiter erhöht. Zur Bestimmung gehört weiter eine Kontrollrechnung, die über den gleichen Zeithorizont mit dem ursprünglichen CO2-Ausgangswert erfolgt. Verdopplungs-

und Kontrollvorgaben werden in ein Klimamodell eingegeben und entsprechende Simulationsrechnungen vorgenommen. Das Ergebnis ist die Klimasensitivität als Temperaturdifferenz aus den durchschnittlichen globalen Oberflächentemperaturen beider Simulationsläufe.

Ein solches Ergebnis basiert, wie gesagt, auf einer Simulation. Es kann nicht durch Messungen verifiziert werden. Unter Laborbedingungen, also ohne Rückkopplungen durch andere Klimaereignisse, führt

eine CO2-Verdopplung zu einer Erwärmung von 1,2 ºC12. Rückkopplungen können sowohl dämpfend als auch verstärkend wirken. Alle bisherigen IPCC-Berichte gehen davon aus, dass per Saldo verstärkende Rückkopplungen vorliegen.

Die Simulationsrechnungen der verschiedenen Klimamodelle liefern unterschiedliche quantitative Ergebnisse, bei gleicher Tendenz (verstärkend) gegenüber dem o.g. Laborwert. Dabei streuen vorrangig

die oberen Temperaturwerte. Die Ergebnisse werden zusammengefasst und einer Fehlerdiskussion unterzogen. Das Endergebnis ist eine rechnerische Größe mit Angabe ihrer 95%-igen ± -Abweichung.

Wertung der Computermodellierung und -simulation

Ausgang

Bevor auf spezifische Fragen der Computermodellierung und -simulation im 4. IPCC-Bericht eingegangen wird, ist eine grundsätzliche Aussage voran zu stellen:

Ein Computermodell simuliert ganz allgemein Abläufe von Vorgängen und Ereignissen, die sowohl real als auch fiktiv sein können. Auf drastische Weise hat John von Neumann, der wohl bedeutendste

Mathematiker des 20.Jahrhunderts, die Möglichkeit beschrieben, die Ergebnisse einer Simulation zu variieren: „Give me four adjustable parameters and I can simulate an elephant. Give me one more and I can make his trunk wiggle“.

Als Analogon bietet sich ein Theaterstück oder ein Spielfilm an. Auch ein Spielfilm enthält Abläufe von Vorgängen und Ereignissen, welche zwischen der Realität und der Fiktion angesiedelt werden können. Der entscheidende Unterschied zwischen Computermodell und Film ist, dass ein Computermodell in sich logisch widerspruchsfrei ist, was bekanntlich von Filmen nicht behauptet werden kann. Computermodellierung und -simulation sind angewandte Mathematik.

Wird diese Aussage auf den vorliegenden Bericht angewendet, hat sich eine kritische Wertung vor allem mit dem Vergleich Realität – Simulation zu befassen. Die Realität wird hierbei durch statistisch erfasste und aufbereitete Messdaten und aus diesen abgeleiteten Daten sowie Schätzwerten repräsentiert. Sie werden in Zeitreihen angeordnet, um die Dynamik des Klimas darzustellen. Ferner sind die aus Messungen gewonnenen

Daten fehlerbehaftet. Aktuelle Daten weisen in der Regel geringere Fehler auf als Daten aus der Vergangenheit, direkt gemessene Werte (z.B. die Temperatur) sind genauer als solche, die aus anderen Daten errechnet oder geschätzt wurden.

Die Güte der Computermodellierung und -simulation ergibt sich aus der Vollständigkeit der im Modell erfassten relevanten Klimaereignisse und deren realitätsgetreuen Darstellung im Computer.

Wie bereits ausgeführt, liegen den Modellkomponenten Algorithmen und Randbedingungen der Navier-Stokes-Gleichungen zugrunde. Die Algorithmen werden im Bericht hinsichtlich ihres Übereinstimmens mit dem realen Geschehen eingeschätzt. Die Einschätzung, der so genannte Grad des wissenschaftlichen Verständnisses (level of scientific understanding – LOSU), wird den Klimaereignissen zugeordnet.

Er bewegt sich zwischen hoch (high) und sehr niedrig (very low)13.

Computermodelle setzen immer die auf anderen Wegen gewonnenen Daten voraus. Modelle berechnen innerhalb des zugrunde liegenden Datenbereichs weitere Daten durch Interpolation, wobei die dabei auftretenden

Fehler annähernd gleich sind. Wird der Datenbereich verlassen (Extrapolation), nimmt mit wachsender Entfernung die Fehlergröße zu und die Simulationsergebnisse werden zunehmend wertlos.

Klimamodelle

Kennzeichnend für alle Klimamodelle ist, dass sie eindeutig auf die Untersuchung des Einflusses der Treibhausgase ausgerichtet sind. Dies gilt definitionsgemäß für die einfachen Klimamodelle, aber auch für die EMIC. Die AOGCM scheinen auf den ersten Blick davon ausgenommen. Werden aber zusätzlich die Systembeschreibungen ausgewertet, zeigt sich, dass es Erweiterungen und Neuinstallationen nur bei den Modellkomponenten gibt, die zur Simulation des Treibhausgas-Effektes beitragen. Die Zielstellung der Simulationsrechnungen ist daher nicht ergebnisoffen. Der Grund für das Bevorzugen des Treibhausgas-Effektes wird im Bericht nicht diskutiert. In einer Systembeschreibung14 wird ausgeführt, dass das Klimageschehen der letzten 40 Jahre allein durch das Wirken von Treibhausgasen dargestellt werden kann. Daraus ließe sich schlussfolgern, dass Gleiches auch für die nähere Zukunft gilt. Sobald aber das letzte Jahrhundert ausschließlich mit dem Treibhausgas-Antrieb simuliert wird, ergeben sich Temperaturwerte, die beträchtlich über den gemessenen (1,2 ºC zu 0,8 ºC) liegen. Erforderlich sei, andere Antriebe wie Aerosole, die Vulkantätigkeit, Änderungen des Ozongehaltes und die Sonnenaktivität zu berücksichtigen. Diese Antriebe sind jedoch bei weitem nicht so erforscht wie die Treibhausgase. Das führe dazu, dass die

Computermodellierung mehr eine Kunst als eine Wissenschaft werde. Die Betrachtung schließt mit „You may believe the future predictions of global temperatures by models are valid, but do you trust them more than the statistician?”

Komponenten, die sich mit der Sonnenaktivität befassen, sind in einigen AOGCM implementiert. Sie simulieren dort die Milankovitch-Zyklen, welche die Stellung der Erdachse und Änderungen der Erdbahn

um die Sonne beschreiben. Sonnenfleckenperioden und der Einfluss der Höhenstrahlung (z.B. auf die Wolkenbildung) werden in den Systembeschreibungen nicht erwähnt.

Allerdings wurde nur ein Teil der Systembeschreibungen ausgewertet, die zu den AOGCM des 4. IPCC-Berichtes gehören.

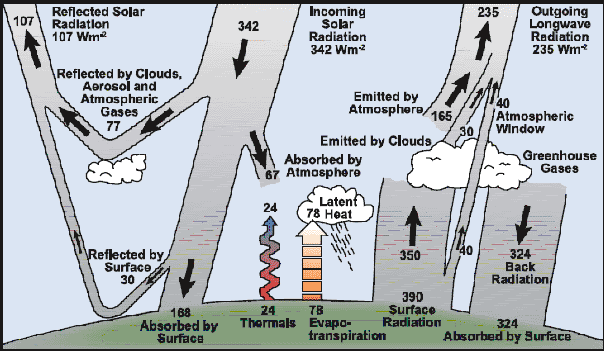

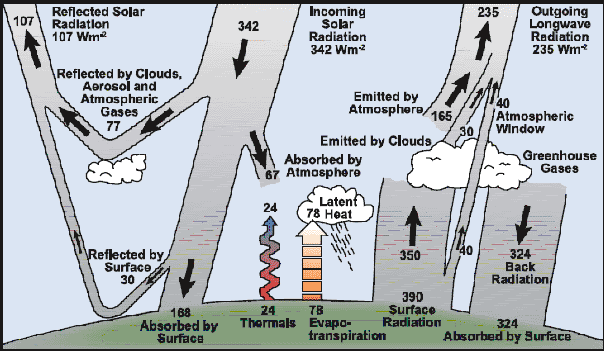

Zu berücksichtigen ist ferner das Wirken des Programms für Klimamodell-Diagnose und -Vergleich (PCMDI). Ein solches Programm ist notwendig, um die Vergleichbarkeit zwischen den Ergebnissen der Klimamodelle herzustellen. Gleichzeitig trägt es dazu bei, die Modellkomponenten auch programmierungstechnisch zu vereinheitlichen. So darf davon ausgegangen werden, dass die so genannte durchschnittliche jährliche Energiebilanz der Erde15

(Abb.1) auch quantitativ in allen AOGCM implementiert ist.

Damit ist den Modellen ein Verhalten aufgeprägt, das beispielsweise den Saldo bei den Rückkopplungen immer positiv werden lässt. Auch erklärt es den Effekt, dass verschiedene Klimamodelle für bestimmte Erdregionen die gleichen Ergebnisse liefern. Dies wird gelegentlich als Beweis für die Übereinstimmung von Simulation und Realität genannt. Davon kann keine Rede sein. Nutzen die zur Simulation vorrangig beitragenden Modellkomponenten die gleichen Fortran-Programme, wären im Gegenteil unterschiedliche Ergebnisse zu hinterfragen.

Abb. 1: Durchschnittliche jährliche (Strahlungs-)Energiebilanz der Erde

Die Hockeyschlägerkurve

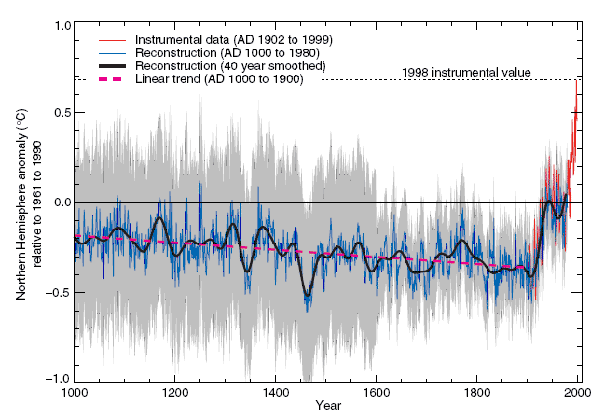

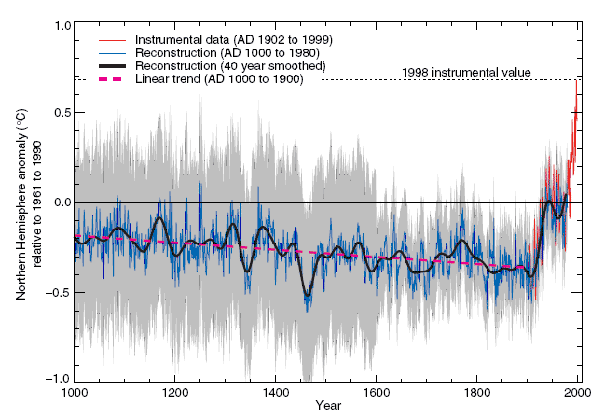

Ein Beispiel für das Vermischen von Realität und Fiktion ist die so genannte Hockeyschlägerkurve, die im 3. IPCC-Bericht von 2001 veröffentlicht wurde (Abb. 2). Das Diagramm zeigt die

Rekonstruktion des Temperaturverlaufs auf der nördlichen Hemisphäre bezogen auf die mittlere Temperatur von 1961 bis 1990. Die Temperaturwerte wurden aus Daten von Baumringen und Eiskernen abgeleitet sowie den Messreihen der Wetterstationen entnommen. Auffällig ist der lineare Verlauf von 1000 bis 1900 mit dem anschließenden steilen Anstieg, was der Kurve ihren Namen gab. Der lineare Verlauf ist umso verwunderlicher, weil jeder einigermaßen in der europäischen Geschichte Beschlagene die kalten Jahrhunderte der Kleinen Eiszeit in der Darstellung erwartet. Ebenso entspricht der Verlauf auch nicht der Vorstellung vom damaligen Klima, das

bei der Besiedlung von Grönland durch die Wikinger um das Jahr 1000 herrschte. Immerhin wuchs damals auf Neufundland und Wein.

Abb. 2: Rekonstruktion des relativen Temperaturverlaufes auf der nördlichen Hemisphäre16

Formal ist alles in Ordnung. Der Trendberechnung wurde die Gerade vorgegeben, sie liefert ein Ergebnis, das mathematisch korrekt ist. Es stimmt nur nicht mit der Realität überein. Der 4. IPCC-Bericht

enthält nicht mehr die Hockeyschlägerkurve, er bietet dafür die Erklärung an, dass die letzten 1000 Jahre regional durch sehr heterogenes Klima gekennzeichnet waren. Auch wird eingeräumt, dass um das

Jahr 1000 in einigen Regionen das Klima wärmer als im 20.Jahrhundert gewesen sein könnte17. Nicht zulässig sei aber daraus zu schlussfolgern, dass die mittelalterliche Warmzeit weltweit geherrscht habe. Dies gebe das vorhandene Datenmaterial nicht her, da es sowohl qualitativ als auch quantitativ nicht ausreichend sei.

Warum aber wurde die Hockeyschlägerkurve veröffentlicht? Die Vermutung liegt nahe: zur Stützung der Treibhausgas-These. Diese lautet, dass mit mindestens 90%-iger Wahrscheinlichkeit menschliche

Aktivitäten (durch Freisetzen von Treibhausgasen) seit 1750 zu einem Anwachsen des globalen durchschnittlichen Strahlungsantriebes um 1,6 (0,6 bis 2,4) Wm-2 geführt haben18.

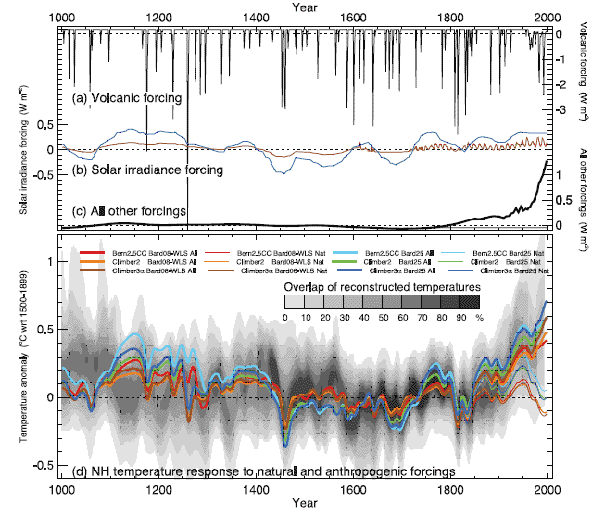

Treibhausgase haben jedoch bis in das 19. Jahrhundert hinein keine klimaverändernde Rolle gespielt (Abb.3). Wenn nun globale Temperaturschwankungen mit vergleichbaren Amplituden auch vor Beginn der Moderne auftraten,

welche Strahlungsantriebe waren es dann? Sind es die Sonne und die Vulkantätigkeit oder andere, bislang nicht berücksichtigte Antriebe? Der 4. IPCC-Bericht räumt zumindest der Sonnenaktivität einen gewissen

Einfluss ein, die Treibhausgas-These aber bleibt bestehen. Es findet ein Wechsel in der Argumentation statt, von der offensiven im 3. Bericht, bei der mit Fiktionen gearbeitet wird, zur defensiven des 4. Berichtes. Hier stütze

das vorhandene Datenmaterial gleich hohe Temperaturschwankungen nur in ausgewählten Erdregionen, eine Extrapolation auf die Gesamterde sei unzulässig, da mit zu großen Fehlern behaftet.

Diese Beweisführung ist kaum zu widerlegen. Das Wissen über das Klima im Jahr 1000 ist sehr bruchstückhaft. Auch sind die vorliegenden Klimarekonstruktionen teilweise nicht miteinander vergleichbar.

Klimadaten aus Baumringen und aus Eisbohrkernen können erst seit 2008 zeitlich synchronisiert werden19.

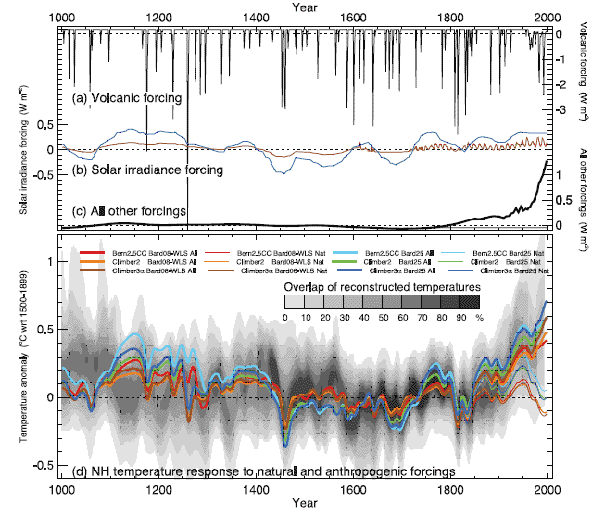

Abb. 3: Simulation der Temperaturänderungen in den letzten 1000 Jahren20

Die o.g. Aussagen zur Hockeyschlägerkurve betreffen die Rekonstruktion der Klimadaten der letzten 1000 Jahre, also die Klimarealität. Welche Ergebnisse bringt die Simulation für diesen Zeitraum?

Abb. 3 zeigt die Ergebnisse der Simulationsrechnungen dreier EMIC, denen die nach Wahrscheinlichkeit zusammen gefassten Daten der Rekonstruktion (schwarz = hoch, hellgrau = gering) unterlegt wurden. Die dicken Linien stellen

die Ergebnisse mit allen Antrieben, die dünnen ohne die Treibhausgase dar. Die Verläufe trennen sich ab der Mitte des 19. Jahrhunderts. Zusätzlich werden die zugrunde liegenden Strahlungsantriebe (Vulkantätigkeit,

zwei Varianten der Sonnenaktivität und die übrigen Antriebe) im zeitlichen Verlauf dargestellt.

Eine Diskussion der Simulationsergebnisse wird hierbei immer subjektiv sein. Der Anhänger der Treibhausgas-These sieht mit den Verläufen ab 1850 seine Ansichten bestätigt, der Skeptiker wird auf die teilweise negative Korrelation von Rekonstruktion und Simulation hinweisen. Hat man die Aussage des Berichts im Hinterkopf, dass das Datenmaterial für die Rekonstruktion sehr fehlerbehaftet ist, ist die Simulation größtenteils wertlos. Hier ist mehr Kunst als Wissenschaft am Werke.

Fehlerbetrachtungen

Ein Klimamodell besteht aus Modellkomponenten, welche die Klimaereignisse simulieren. Die Qualität der Simulation eines Ereignisses ist abhängig von den zugrunde liegenden Algorithmen und Randbedingungen,

die Güte des Modells vom sachgerechten Zusammenspiel und der Vollständigkeit der Modellkomponenten. Man mag von seinem eigenen Modell überzeugt sein, erst der Vergleich der Ergebnisse mit auf anderem Wege gewonnenen verlässlichen Daten gibt Gewissheit.

Wie steht es nun um die Belastbarkeit der aus der Realität stammenden Daten? Wie bereits ausgeführt, gibt es erst seit etwa 50 Jahren Datenmaterial, das der Forderung nach umfassender globaler Gültigkeit gerecht wird. Je weiter in die Vergangenheit gegangen wird, desto geringer die Flächendeckung und desto schwächer die Verlässlichkeit der Klimadaten21.

Hier stellt sich folgende Frage: Wenn schon das Datenmaterial der Zeit vor 1000 Jahre nicht ausreicht zu entscheiden, ob das Erdklima damals wärmer oder kälter als heute war, wie gelingt es dann,

ein Klimamodell mit den Daten des letzten Eiszeit-Maximum (vor 21.000 Jahren) zu justieren? Zur Erinnerung: Justiert wird, indem ein Modell sowohl für die jetzige Zeit als auch für das Eiszeit-Maximum zahlreiche

Variantenrechnungen durchführt, aus denen dann (durch Menschen) die Ergebnisse aussortiert werden, welche das jeweilige Klima nicht realistisch wiedergeben. Wie aber sah das realistische Klima vor 21.000 Jahren aus? Ohne

Zweifel ist das Wissen darüber weitaus geringer und ungenauer als zum aktuellen Klima. Es ist daher mit Annahmen und Schätzungen zu arbeiten. Das hat für die Modelljustierung zur Folge, dass ein systematischer

Fehler, dessen Größe nicht bekannt ist, der Simulation aufgeprägt wird.

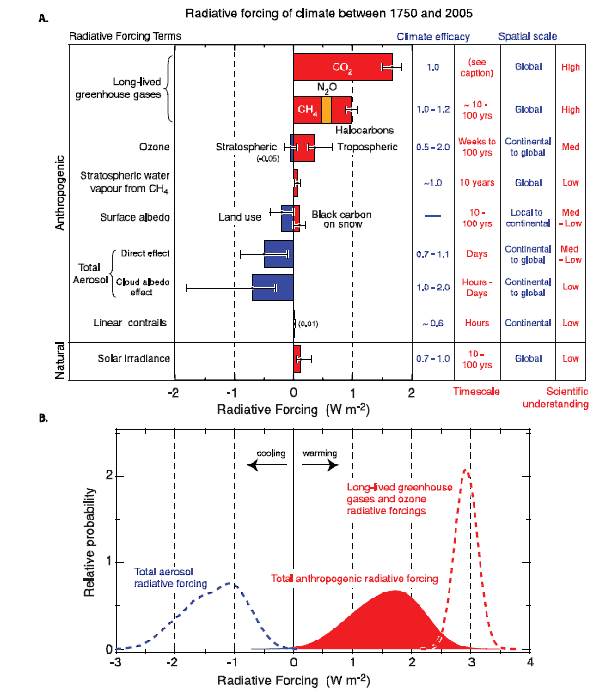

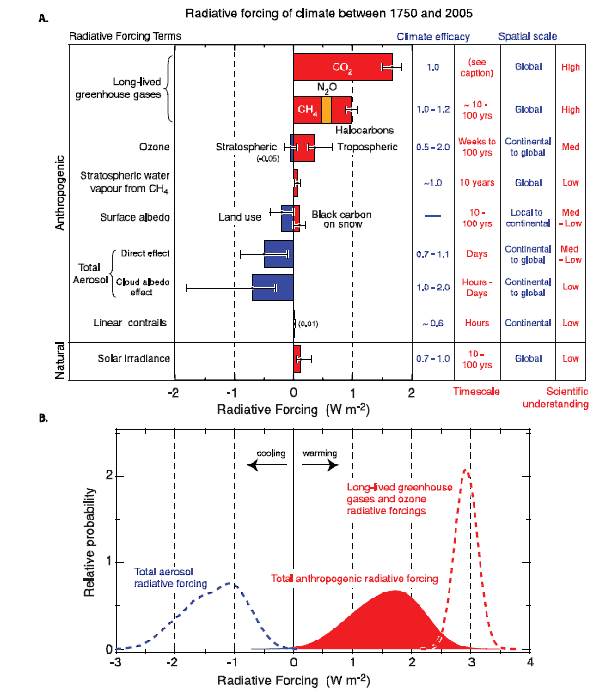

Das zusammen gefasste Ergebnis des 4. IPCC-Berichts wird in Abb. 4 dargestellt. Es zeigt im Diagramm A den Anteil der einzelnen Strahlungsantriebe (Treibhausgase, Ozon, stratosphärischer Wasserdampf

aus der Methan-Aufspaltung, Albedo der Erdoberfläche, Aerosole (direkter Einfluss und durch Wolkenbildung), Kondensationsstreifen von Flugzeugen sowie die Sonnenaktivität). Die Anteile wärmen oder kühlen,

sie werden nicht als absolute Werte sondern als Änderungen zum Bezugswert von 1750 ausgewiesen. Unter der Klima-Wirksamkeit (climate efficacy) wird das Verhältnis der Klimasensitivität eines Antriebes zur Sensitivität des CO2 verstanden. Die Zeitskala sagt aus, nach welcher Zeitspanne ein Strahlungsantrieb wieder aus der Atmosphäre verschwunden ist. Die Bereichs-Skala (spatial scale) benennt den Bereich, in dem ein Antrieb wirkt. Der Grad des wissenschaftlichen Verständnisses gibt die Einschätzung zum Wissen über den jeweiligen Antrieb wieder.

Abb. 4: Änderungen der Strahlungsantriebe zwischen 1750 und 200522

Das untere Diagramm B zeigt die zusammen gefassten Antriebe in ihrer Wahrscheinlichkeitsverteilung (bei 90 % Fehlerintervall). Nur bei den Treibhausgasen wird Normalverteilung angenommen, die Aerosole und

die anthropogenen Antriebe zeigen abweichende Verteilungen, die sich nach Anwendung der Monte-Carlo-Methode einstellen.

Die Änderung des Antriebs wird in Watt/m2 angegeben. Dieser Wert ist eine reine Rechengröße und Ergebnis der Simulation. Es gibt keine Messdaten zu einzelnen Strahlungsantrieben.

Wie stimmen die in Abb. 4 gezeigten Antriebe zu den Klimaereignissen mit der Realität überein? Der Bericht enthält dazu keine direkte Aussage. Der zugehörige Grad des wissenschaftlichen Verständnisses (LOSU) gibt lediglich die Meinung der Fachleute wieder, die im Rahmen des Berichts mit dem speziellen Klimaereignis befasst sind. Ist der Grad hoch, bedeutet dies gute bis sehr gute Übereinstimmung unter den Fachleuten, ist er niedrig, werden sehr unterschiedliche Ansichten diskutiert. Der LOSU ist demnach nicht von subjektiven Einflüssen frei, zur Beurteilung, wie Simulation und Realität übereinstimmen, ist er nur mit Vorbehalten nutzbar.

Gemäß Abb. 4 wird das Wirken der Treibhausgase gut verstanden. Dies basiert vor allem auf den Messwerten. Zwar liegen präzise Messungen erst seit 1958 vor23.

Es gibt jedoch Eiskerne aus der Antarktis, aus denen mit einer Auflösung von ca. 10 Jahren der CO2-Anteil der Atmosphäre zeitabhängig rekonstruiert wurde.

Wie sieht es aber bei den Aerosolen aus? Hierbei wird zwischen den direkten und indirekten Effekten unterschieden. Beim direkten Effekt zerstreuen und absorbieren die Aerosole die kurzwellige und langwellige

Strahlung, wobei sie die Strahlungsbilanz der Atmosphäre verändern. Der indirekte Effekt beeinflusst die Stärke und die Dauer der Wolkenbildung. Wolken tragen entscheidend zu der Erd-Albedo bei.

Der 4. IPCC-Bericht kommentiert ausgiebig die Fortschritte, die sowohl bei den Messverfahren als auch in der Simulation von Wolkenbildung und Albedo seit dem 3. Bericht getätigt wurden. Trotzdem wird

der LOSU des Albedo-Effekts durch Wolken als niedrig eingeschätzt. Gründe dafür liegen in den Messverfahren und in der Modellierung. Als Mängel bei den Messverfahren werden die zu grobe Auflösung der

Satellitenmessungen und das Nichtunterscheiden von anthropogenen und natürlichen Aerosolen genannt. Die Hauptschwäche der Modellierung sei das geringe Wissen über Quantität und Verteilung anthropogener

Aerosole, besonders in der präindustriellen Zeit. Weiterhin versagen die AOGCM bei der Simulation der Aerosol-Wolken-Interaktion, weil die dafür erforderliche kleinteilige Auflösung nicht geleistet werden kann.24

Im Übrigen simulieren lediglich neun der 23 AOGCM den indirekten Effekt.

Die Albedo beeinflusst wesentlich das Temperaturgleichgewicht der Erde. Die Erd-Albedo beträgt ca. 30 %, Wolken sind daran zu etwa zwei Drittel beteiligt. Verringert sich die Albedo um ein Prozent, erhöht sich die mittlere Temperatur um 1 ºC und vice versa. Dieser Wert entspricht ungefähr dem, der durch die langwellige Strahlungsänderung einer CO2-Verdopplung erreicht wird.25

Die im 4. Bericht enthaltenen Aussagen über Aerosole tragen nicht dazu bei, den zugehörigen Ergebnissen zu vertrauen. Als geradezu abenteuerlich muss die Angabe gelten, wonach seit 1750 der Strahlungsantrieb

des Albedo-Effekts durch Wolken sich um -0,7 (-0,3 bis -1,8) Wm-2 geändert hat (Abb. 4). Auf welche Weise wurde der Antrieb für das Jahr 1750 bestimmt, wenn weder die Messverfahren noch die Modellierung

hinreichend korrekt arbeiten?

Weiter stellt sich die Frage, warum für den zusammen gefassten Antrieb kein LOSU angegeben wird. Der Bericht gibt darauf keine Antwort. Dass eine Antwort von Bedeutung ist, hat der Verfasser selbst erfahren.

Im Vortrag zum Klimawandel eines Abteilungsleiters des Bundesumweltamtes wurde behauptet, dass mit 99,9%-iger Wahrscheinlichkeit die Simulationen mit dem tatsächlichen Geschehen übereinstimmen. Auf den Einwand, für

Treibhausgase als die am besten erforschten Klimaagenzien gelte gemäß dem 4. IPCC-Bericht, dass die Expertenmeinungen zu lediglich 90 % übereinstimmen, wurde mit Verdächtigungen und persönlichen Unterstellungen geantwortet.

Der zusammen gefasste Antrieb setzt sich aus den Antrieben einzelner Klimaereignisse zusammen, deren Übereinstimmung von Simulation und Realität sehr unterschiedlich ist. Für die Übereinstimmung wird der LOSU als Maß zugrunde gelegt, da nur er zur Verfügung steht. Sicher ist, dass ein LOSU des kombinierten Antriebs beträchtlich niedriger ist als der höchste der Einzelantriebe.26 Die Aussage, es sei höchst wahrscheinlich (extremely likely), dass Menschen einen substantiellen Einfluss auf die Klimaerwärmung haben27, lässt sich folglich nicht aus

dem Ergebnis-Diagramm der Abb. 4 herleiten. Dieses liefert nach der berichtseigenen Sprachregelung28 nur ein about as likely as not für den menschlichen Faktor. Die Frage stellt sich, wie und durch wen das einen Außenstehenden überzeugende extremely likely zustande kam.

Vorausberechnungen

Vorausberechnungen zum zukünftigen Klima gründen sich ausschließlich auf Modellrechnungen. Eine Vorausberechnung ist eine Extrapolation, die auf einem soweit als möglich abgesicherten Ergebnis als Ausgangsbasis und der Vorgabe von Einflussfaktoren basiert. Die Einflussfaktoren sind dabei grundlegende Größen. Die Fehler einer Vorausberechnung bestehen aus dem Fehler der Ausgangsbasis und dem mit

der Entfernung vom Ausgang wachsenden Extrapolationsfehler.

Typisch für Vorausberechnungen sind so genannte Szenarien. Ein Szenario stellt die Simulation eines Vorgangs dar, der einen konkreten Bezug zur Realität hat und für sich plausibel ist. Eine Vorausberechnung setzt sich in der Regel aus mehreren Szenarien zusammen. Erforderlich ist, mit möglichst wenigen Szenarien einen Ereignisbereich zu schaffen, der die wesentlichen Fragen an die Zukunft beantworten kann.

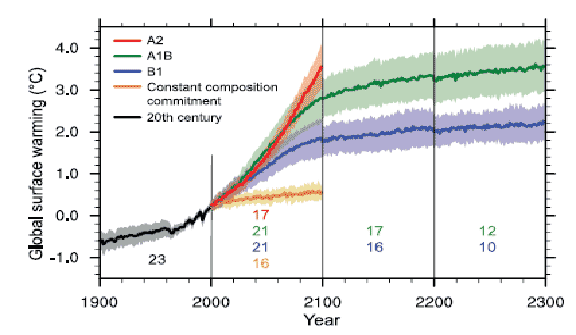

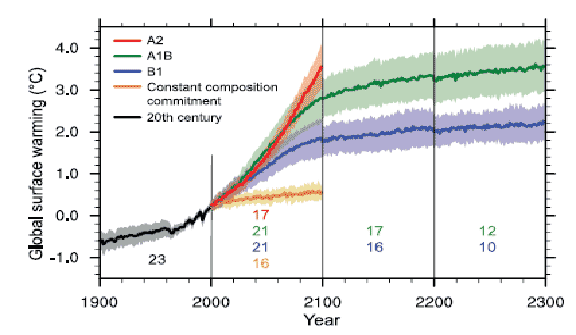

Im Bericht werden vorrangig drei Szenarien behandelt, deren Einflussfaktoren ausschließlich anthropogene Treibhausgase sind. Sie werden als B1(low)-, A1B(medium)- und A2(high)-Szenarien bezeichnet. Jedem Szenario werden spezifische Emissionsverläufe von Treibhausgasen (CO2, SO2, NH4) über die Jahre von 2000 bis 2100 vorgegeben. Mit diesen Eingaben berechnen die Klimamodelle (AOGCM, EMIC, einfache Klimamodelle) die sich einstellenden Gaskonzentrationen, die Strahlungsantriebe und die mittleren globalen Temperaturänderungen29. Das Jahr 2000 ist die Ausgangsbasis, demnach beginnen alle Emissionen mit deren globalen Durchschnittswerten, ausgenommen ist die mittlere globale Temperaturänderung. Deren Bezugsgröße ist die durchschnittliche globale Temperatur der Zeitspanne von 1980 bis 1999. Zusätzlich zu den drei Szenarien werden noch drei weitere so genannte Stabilisationsszenarien erstellt. Beim Ersten bleiben die Vorgabewerte, also die Emissionen, von 2000 für die 100 Jahre zeitlich konstant, Szenario 2 und 3 setzen im Jahr 2100 auf und rechnen 200 Jahre mit den fixen Endwerten der Szenarien A1B und B1 weiter.

Abb. 5 zeigt die Ergebnisse der Szenarien B1, A1B und A2 sowie die Stabilisierungsszenarien für die mittlere globale Temperaturänderung. Die Zahlen an den Verläufen geben die Anzahl der beteiligten Klimamodelle an. Die untergelegten Schatten bezeichnen die Standardabweichungen der jährlichen Mittelwerte der einzelnen Modelle.

Abb.5: Mittlere globale Temperaturänderung der Erdoberfläche gemäß der Szenarien B1, A1B und A2 sowie der Stabilisierungsszenarien30

Wie sind nun diese Vorausberechnungen einzuschätzen? Grundsätzlich ist festzustellen, dass die Zeitspannen der Vorhersage ob ihrer Dauer alle Vorstellungen sprengen. Selbst bei einer im Vergleich zum Klima mathematisch einfachen Sache wie eine Bevölkerungsvorausberechnung (sehr gute Daten als Ausgang und keine Nichtlinearitäten in den Modellen) werden seriöse Aussagen nicht über einen Zeithorizont von 50 Jahren hinaus getroffen. Bei der Voraussetzung, dass der Fehler der Ausgangsbasis vernachlässigbar ist, wird üblicherweise die Vorausberechnung beendet, wenn sich die Vorhersagewerte der einzelnen Szenarien mehr als 20 % voneinander unterscheiden. Dem liegt die Annahme zugrunde, dass mit längerer Vorhersagezeit die Vorgaben für die Szenarien immer unwahrscheinlicher sowie die Ergebnisse beliebiger werden, mithin der Extrapolationsfehler zu groß wird.

Für die in Abb. 5 gezeigten Szenarien ergeben sich folgende Verhältnisse31:

(max. Differenz = (Tmax – Tmin)/ Tmax* 100%)

|

|

Mittlere globale Temperaturänderung (ºC)

|

|

|

2011 – 2030

|

2046 – 2065

|

2080 – 2099

|

|

A2

|

0,64

|

1,65

|

3,13

|

|

A1B

|

0,69

|

1,75

|

2,65

|

|

B1

|

0,66

|

1,29

|

1,79

|

|

Max. Differenz

|

7,2 %

|

26,3 %

|

42,8 %

|

Demnach sollte die Vorausberechnung des Klimageschehens etwa mit dem Jahr 2040 gestoppt werden, wobei der Fehler der Ausgangsbasis nicht berücksichtigt wird. Für die Zeit nach 2040 werden die Ergebnisse

zunehmend wertlos, da sich die Szenarienverläufe immer mehr voneinander unterscheiden. Es ist dann eine Glaubenssache, welchem Szenario der Vorzug gegeben wird.

Die hier vorgetragene Argumentation lässt sich gleichermaßen auf die Ausführungen des 4. IPCC-Berichts zu regionalen Klimavoraussagen32 anwenden. Eine Vorausberechnung liefert qualitative und quantitative Ergebnisse für einen definierten Bereich, im Fall der Abb. 5 ist es die Erde. Die kleinste Flächeneinheit einer globalen Vorausberechnung ist das Gridelement, dessen Fläche, vom AOGCM abhängig, zwischen 15.600 und 160.000 km2 beträgt. Das bedeutet, dass beispielsweise der Freistaat Sachsen mit einer Fläche von 18.415 km2 bei

den meisten AOGCM kleiner als ein Gridelement ist. Damit sind keine oder höchstens sehr eingeschränkte Simulationen möglich.

Seitens der Klimamodelle wird versucht, diesen Mangel zu beheben. Ein Ansatz ist das so genannte genestete Modell (nested regional climate model). In das AOGCM wird ein regionales Klimamodell (RCM) mit entsprechend angepasster Gridelementgröße eingebettet. Die Gridelementgröße beträgt in der Regel 50 x 50 km, es wird aber auch mit kleineren Gridelementen (10 x 10 km) gerechnet. Kennzeichnend für die genesteten Modelle ist der Austausch von zeitveränderlichen Klimagrößen über die Modellgrenzen hinweg. Dies führt gemäß dem 4. IPCC-Bericht zu schwierigen Problemen bei den Randbedingungen33. Die Folgen sind Inkonsistenzen zwischen den beiden Klimamodellen. Über die Güte der so erzeugten regionalen Simulationen gibt der Bericht keine Auskunft. Sie dürfte aber mit Sicherheit geringer als die einer weltweiten Simulation sein.

Die Gridelementengröße beeinflusst die Ergebnisse der Simulationsrechnungen. Einerseits können die Resultate besser dem realen Geschehen entsprechen, beispielsweise bei der Wolkenbildung.

Andererseits ist die Gleichverteilung der Klimaagenzien wie die der Treibhausgase bei kleinerem Gridelement zunehmend nicht mehr gegeben. Bei einem 10 x 10 km-Gridelement ist u.a. zwischen Stadt- und Landregionen zu unterscheiden.

Städte weisen deutlich höhere Durchschnittstemperaturen als ländliche Regionen auf. Neben den erwähnten Inkonsistenzen, also Unterschiede in den Ergebnissen von AOGCM und RCM bei der Vorgabe von Emissionsänderungen, wären noch systematische Fehler unbekannter Größe wegen veränderter und unvollständiger Berechnungsgrundlagen zu erwarten. Alles in allem sollte dies den Zeithorizont der regionalen gegenüber

den weltweiten Vorausberechnungen weiter verkürzen.34

Anfang Mai 2008 wurde die Öffentlichkeit von einer Publikation in der Zeitschrift Nature überrascht35.

Sie sagt nicht mehr und nicht weniger aus, dass sich der Klimawandel eine Pause gönnt. Grund für diese neue Erkenntnis sind offensichtlich Messwerte des letzten Jahrzehnts, die nicht mit den Ergebnissen der Simulationsrechnungen übereinstimmen. Für die Vorausberechnungen hat das zur Folge, dass ihre Ausgangsbasis nicht durch Messdaten gesichert ist und beliebig wird. Die dazu gehörenden Kurvenverläufe sind dann weitgehend fiktional. Die Klimavorausschau des Berichts ist streng genommen Makulatur. Es bleibt abzuwarten, ob der IPCC für die wichtigste Aussage des Band 1 The Physical Science Basis eine Korrektur nachreichen wird.

Fazit

Der Focus der Anmerkungen zum 4. IPCC-Bericht wurde auf die Computermodellierung und -simulation gerichtet. Ohne Zweifel bildet dieser Bereich einen Eckstein des Berichts, erst mit der umfassenden Nutzung

moderner Hard- und Software lässt sich ein so komplexes Wissengebiet wie das Klima der Erde überhaupt systematisch ordnen und in seinen Auswirkungen verstehen. Hervor zu heben ist die immense Leistung, die in der

Computermodellierung und -simulation von Klimaereignissen in einem nun schon Jahrzehnte dauernden Prozess erbracht wurde. Viele Dutzende, wenn nicht Hunderte von Arbeitskräftejahren an Aufwand für Design, Programmierung und Test waren erforderlich, um die Klimamodelle in den heutigen Zustand zu bringen. Viele von ihnen geben ein herausragendes Beispiel für den state of the art der Softwaretechnologie.

Diese Aussage gilt der Computermodellierung und -simulation. Sie ist ein Instrument, das bei der Klimaforschung eingesetzt werden muss. Als Instrument erweitert sie die Möglichkeiten der Klimaforscher um Größenordnungen. Was die Informationstechnologie aber nicht kann, ist den Beweis für die Übereinstimmung der Simulation mit der Realität zu liefern. Auch das Rechnen mit verschiedenen Klimamodellen und das Zusammenfassen der so erhaltenen Ergebnisse helfen da nicht weiter. Nur der Vergleich der Simulationsergebnisse mit auf anderem Wege gewonnenen verlässlichen Daten schafft Gewissheit.

Wie aber sieht die verfügbare andere Datenlage aus? Daten mit umfassender globaler Gültigkeit gibt es seit ca. 50 Jahren, eine für den Anspruch der Klimatologie sehr, sehr kurze Zeit. Wenige Daten aus direkter Messung reichen etwas weiter zurück. Aus ihnen werden fehlende Messwerte errechnet oder geschätzt. Beide Methoden haben den Mangel, dass sie den Fehler der Vergleichsdaten vergrößern, die erste Methode weniger, die zweite mehr. Für eine Wissenschaft, die in Jahrhunderten und Jahrtausenden denkt, eine erbärmliche Ausgangslage. Daraus verbindliche Aussagen zum vergangenen und zukünftigen Klimageschehen zu treffen, erfordert ein ungeheures Maß an Chuzpe.

Aber hat die Klimatologie nicht Erfolg in der Gesellschaft? Ja, sie hat Erfolg, sogar riesigen.

Es ist ein Phänomen, wie eine Orchideenwissenschaft es geschafft hat, sich im Ranking des allgemeinen öffentlichen Interesses so weit oben anzusiedeln. Dies liegt nicht an den ohne Zweifel vorhandenen wissenschaftlichen Erkenntnissen. Was also ist der Grund? Er ist im gesellschaftlichen und psychologischen Bereich zu suchen. Eine Hypothese: In der westlichen Welt weit verbreitet ist das schlechte Gewissen über und die Ängste am eigenen Fortschritt. Ängste entstehen dadurch, dass der Fortschritt immer unverständlicher wird. Die Aussage, der Klimawandel sei menschgemacht und sehr schlimm und vor allem durch die entwickelten Gesellschaften verursacht, entspricht der Gefühlslage vollkommen. Die politischen und medialen Eliten nehmen sie auf und verstärken sie je nach Bedarf. Sie bedienen das schlechte Gewissen und bestätigen das Gefühl, bald in den selbstverschuldeten Niedergang einzutreten.

Was ist zu tun? Die Regeln der Wissenschaft gelten weiter. Aussagen, von denen behauptet wird, wissenschaftlich zu sein, müssen falsifiziert werden können. Dieser Prozess ist unabhängig von Mehrheiten, auch von demokratisch hergestellten. Notwendig ist, die Publikationen und Verlautbarungen des IPCC auf deren wissenschaftlichen Gehalt abzuklopfen und die Ergebnisse zu veröffentlichen. Optimistisch wird erwartet, dass die so vorgebrachten Argumente schließlich wirken, spätestens dann, wenn der Bevölkerung wegen des „menschgemachten“ Klimawandels große Kosten aufgebürdet werden.

Die prognostizierten Kosten belaufen sich auf Abermilliarden. Es ist festzustellen, dass der Großteil der Medien und die Politik aktuell die Aussage des IPCC kritiklos hinnehmen, der Klimawandel sei höchst wahrscheinlich menschgemacht. Warum wird, wie bei Geldgeschäften üblich, nicht ein Gutachten unabhängiger Dritter eingeholt? Die Milliarden können nur einmal ausgegeben werden, was ist, wenn sich der „menschgemachte“ Klimawandel als nicht existent herausstellt?

1 Falsification Of The Atmospheric CO2 Greenhouse Effects Within The Frame Of Physics, 2007,

Gerlich., p.81

2 IPCC AR4 Chapt. 8.1.3

3 Russell, G.L., 2005: 4×3 Atmosphere-Ocean Model Documentation,Grid. http://aom.giss.nasa.gov/doc4x3.html

4 IPCC AR4 Chapt. 8.2

5 IPCC AR4 Chapt. 8.2.7

6 IPCC AR4 Chapt. 8.8.2

7 IPCC AR4 Chapt. 8.8.3

8 Claussen, M., 2005: Table of EMICs. http://www.pik-potsdam.de/emics

9 http://www-pcmdi.llnl.gov/ipcc/about_ipcc.php

10 IPCC AR4 Chapt. 6.4.1.3

11 Der Klimawandel, S.Rahmstorf, H.J.Schellnhuber, C.H.Beck, 2006

12 Der Klimawandel, S.Rahmstorf, H.J.Schellnhuber, C.H.Beck, 2006

13 IPCC AR4 Chapt. 2.9.1

14 Russell, G.L., 2005: 4×3 Atmosphere-Ocean Model Documentation, Introduction. http://aom.giss.nasa.gov/doc4x3.html

15 IPCC AR4 S. 96

16 IPCC-TAR 2001, The Scientific Basis, p. 134

17 IPCC AR4 Box 6.4

18 IPCC AR4 Summary for Policymakers, p.3

19 http://www.uni-heidelberg.de/presse/news08/pm280402-3bau.html

20 IPCC AR4 Chapt. 6.6.3.4

21 IPCC AT4 Chapt. 6.1.2.3

22 IPCC AR4 Chapt. 2.9.2

23 IPCC AR4 Chap. 2.3.1

24 IPCC AR4 Chap. 2.4.4.5

25 IPCC AR4 Chap. 1.5.2

26 Die mathematisch begründete Berechnung eines zusammen gefassten LOSU kann nicht gegeben werden.

Eine Abschätzung, die auf dem Schwergewicht (Produktsumme aus |Differenz des Antriebswerts| x LOSU, geteilt durch die Gesamtantriebsdifferenz) basiert, kommt zu einem Gesamt-LOSU von ca. 0,6. LOSU-Angaben entsprechen

hierbei high=0,9, medium=0,5, medium-low=0,35, low=0,2.

27 IPCC AR4 Executive Summary, S. 131

28 Guidance Notes for Lead Authors of the IPCC Fourth Assessment Report on Adressing Uncertainities, Table 4

29 IPCC AR4 Chap. 10, Fig. 10.1, Fig. 10.26

30 IPCC AR4 Chap. 10, Fig. 10.4

31 IPCC AR4 Chap. 10, Table 10.5

32 IPCC AR4 Chap. 11

33 IPCC AR4 Chap. 11 S. 919

34 Der Freistaat Sachsen hat solche regionale Vorausberechnungen vornehmen lassen. Sie folgen dem gleichen zeitlichen Schema wie

die weltweiten Prognosen. Es ergeben sich dann skurrile Resultate. So wurde bei einer Präsentation eine Ergebniskarte gezeigt, die für einen Teil des Lausitzer Berglandes (die Gridelementengröße betrug

10 x 10 km) im Jahr 2089 für die Höhenlinie 500 m einen Temperaturzuwachs von 4,2 ºC auswies.

35 Keenlyside, N. S., M. Latif, J. Jungclaus, L. Kornblueh, and E. Roeckner, 2008: Advancing Decadal-Scale Climarediction in the North Atlantic Sector. Nature, 453, 84-88