Die Klimakatastrophe – was ist wirklich dran?

Posted by Rauch on 16th November 2006

Bitte schnell lesen, bald könnte es nicht mehr erlaubt sein. Frau Beckett, vormalige Umweltministerin in Großbritannien und jetzige Außenministerin behauptete.

„On Thursday (16.11.06), Margaret Beckett, the Foreign Secretary, compared climate sceptics to advocates of Islamic terror. Neither, she said, should have access to the media.“ 1

Im November 2006 versammelten sich in Nairobi 6000 Klimaoffizielle, um gemeinsam der kommenden „Klimakatastrophe“ das Wort zu reden. Die Speisung der oberen 6000 funktioniert aufs Prächtigste die Fütterung der Medien hierzulande noch besser. Sämtliche Medien in deutschen Landen hyperventilieren ob dieser wunderbaren Katastrophe und beschicken Talkshows und Sendungen, sowie viele Artikel mit den wunderbarsten und schrecklichsten Grafiken, über das kommende Unheil, das die ganze Menschheit (darunter geht es nicht) bedrohen soll. Sogar Kofi Annan kann es nicht lassen, von der größten Katastrophe zu sprechen, die die Menschheit je bedroht hat. Und der sich auch darin gefiel die sog. Klimaskeptiker zu einer gefährlichen Minderheit zu erklären. Zitat2 “This is not science fiction, These are plausible scenarios, based on clear and rigorous scientific modeling.A few diehard skeptics continue trying to sow doubt. They should be seen for what they are: out of step, out of arguments and out of the time“.in Deutsch: „ Das ist nicht Science Fiction, das sind plausible Scenarios, basierend auf strenger, wissenschaftlicher Modellierung. Es sind (nur) einige wenige hartgesottene Skeptiker, die versuchen Zweifel zu säen. Sie sollten gesehen werden als das wofür sie stehen. Aus dem Takt, außerhalb von Argumenten und aus der Zeit“ Zitatende. Nun, da hat wohl einer dem Secretary General mehrere ordentliche Bären aufgebunden. Besonders was die „plausible scenarios, based on clear and rigorous scientific modeling“ betrifft „.Wir werden das im Folgenden untersuchen. Also, was hat es denn nun mit dem so oft beschworenen Klimawandel wirklich auf sich? Hier der Versuch einer nüchternen Bestandsaufnahme. Dazu ist es am Besten die folgenden Fragen der Reihe nach und nach aktuellem Stand der Wissenschaft zu beantworten.

1. Gibt es eine wesentliche Erwärmung über die normalen Schwankungen hinaus?

2. Ist der CO2 Anstieg der in der Atmosphäre seit ca. 100 Jahren zu beobachten ist, die wesentliche Ursache dafür? Und wenn ja, hat der Mensch mit seiner technischen CO2 Erzeugung daran einen maßgeblichen Anteil?

3. Ist dieser Klimawandel insgesamt schädlich oder eher nützlich?

und

4. Können wir, die Menschheit insgesamt, realistischerweise etwas dagegen tun?

Kapitel 1

Gibt es eine wesentliche Erwärmung über die normalen Schwankungen hinaus?

Schon diese einfach klingende Frage ist nicht einfach zu beantworten. Warum? Es gibt schlicht keine präzisen Aufzeichnungen der Durchschnittstemperatur der Erde, noch der nördlichen Halbkugel, die präzise Aussagen über mehrere hundert Jahre zulassen. Was es gibt -und es wird auch genutzt- sind indirekte Messungen aus Baumringen, Ernteaufzeichnungen, historische Beschreibungen, Isotopenbestimmungen in Eisbohrkernen etc. Seit ca. 145 Jahren gibt es dazu breit angelegte methodische Temperaturaufzeichnungen3, erst in Europa, dann in den USA und Australien zum Schluß auch im Rest der Welt. Im Jahre 1970 waren weltweit ca. 6000 Wetterstationen im Einsatz. Danach wurde abgebaut auf nur noch 1400 lt WMO. Erst seit 1979 umrunden Wettersatelliten die Erde, die eine verläßliche Datenbasis für die Entwicklung der Durchschnittstemperaturen der oberen Atmosphärenschichten geben.

Die Durchschnittstemperatur der Erde

Warum ist das denn so kompliziert, fragt man sich, ein Thermometer lesen kann doch jeder. Sicher, nur nicht alle gleich gut, nicht alle gleich genau und nicht alle regelmäßig genug und vor allem: Diese Thermometer zeigen die Gesamttemperatur der lokalen Umgebung in ca. 2 m Höhe an. Und diese Umgebung änderte sich fast überall rasant im Laufe der letzten ungefähr 145 Jahre. John Daly, ein privater Klimaforscher der ersten Stunde, hat sich der mühsamen Aufgabe unterzogen, die Genauigkeit und Zuverlässigkeit dieser bodennahen Meßstationen

zu überprüfen. Er fand heraus4 daß nur eine sehr kleine Anzahl von Bodenmeßstationen – die ausschließlich in menschenleeren Zonen in den entwickelten Ländern liegen, zuverlässige Zeitreihen für die Temperaturen erbringen. Diese und nur diese stimmen dann sehr genau mit den Satellitenmessungen überein, auch mit den Wetterballonmessungen, reichen aber für eine Durchschnittsbildung der ganzen Erde oder auch nur der nördlichen Halbkugel, bei weitem nicht aus. Ihre Distanz zueinander beträgt tlw. um die 2000 km und mehr, d.h. die Temperaturen von Berlin und Madrid würden miteinander verglichen. Tatsache ist, daß kein Mensch weiß,

wie groß die Erwärmung wirklich ist, zumal die zugrundeliegenden Datenkollektive stets verändert werden, so wie die Inflationswarenkörbe! Die Globaltemperatur von 1860 z.B. beruhte nur auf 300 nordhemisphärischen

Wetterstationen. Heute sind es nach WMO 1400, wobei für je eine Fläche von 250 000 km2 (Gitterpunktweite 250 km) eine Temperatur genommen wird, die vorher noch auf NN reduziert wurde mit einem mittleren Gradienten von 0,65° C pro 100 m nach unten. Bleibt außerdem noch zu erwähnen, daß 70 % der Erdoberfläche von Wasser bedeckt sind und aus mehrmals pro Jahr über die Gitterquadrate fahrende Schiffe aus Schöpfeimern Jahresmitteltemperaturen konstruiert werden. Die Gruppe um Phol Jones hat 1982 erstmals die Zeitreihe 1860-1980, die zu den angeblichen 0,6° C führten, konstruiert, natürlich strengst wissenschaftlich!! Das kann nicht gut gehen. Als das IPCC (International Panel on Climate Change, der UN Arm für diesen Wirbel) sich zur Vorbereitung des kommenden Assessments No. 4 mit dieser Frage auseinandersetzte, stellten sie fest, daß nur die beiden Meßmethoden: Wetterballon und Satellitenmessung; sehr gut übereinstimmen, starke Abweichungen aber sind zu den terrestrischen Messungen gegeben (Sie zeigen – wider alle Theorie, die höhere Temperaturen gerade in den oberen denn in den unteren Luftschichten fordert – deutlich zu hohe Werte an). Statt nun diese Werte wegzulassen, einigte man sich darauf, daß diese Unterschiede- die sehr gravierend sind und vor allem in den Vorhersagemodellen wirken- , Ursachen in einer noch unverstandenen Atmosphärenphysik hätten, die es genauer zu untersuchen gälte. So schafft man Arbeitsplätze in Wissenschaft Forschung und Verwaltung.

Die aktuelle Entwicklung

Sei es wie es sei: Bis 1979 sind alle Experten auf ungenaue und zu hohe Temperaturmeßreihen angewiesen, seit dieser Zeit nicht mehr. Das folgende Bild zeigt daher die bis ca. 1860 nur indirekt erforschte, ab 1860 mit vielen Unstimmigkeiten gemessene und seit 1979 gemessene Temperaturkurve der Erde.

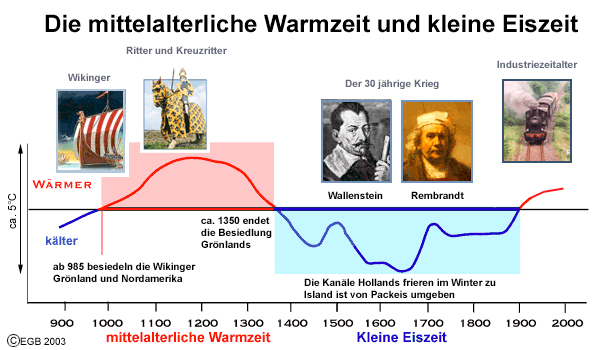

Wie man sieht, gab es einen dicken Buckel im Mittelalter, die Experten streiten sich noch, ob dieser Buckel etwas größer oder etwas kleiner als + 2 ° C über unserer heutigen Durchschnittstemperatur gelegen hat. Drüber lag er auf jeden Fall. Man erinnere sich an die Schulzeit, daß die Wikinger im Jahre um 980 Grönland besiedelten. Immerhin soweit erwärmt, daß es die Besiedlung und den Ackerbau (Grünland) erlaubte. Oder wie Menzies glaubt, daß die Chinesen um 1420 mit ihren Erkundungsflotten auch das arktische Meer befuhren und dort kaum Eis vorfanden. Es war eben schön warm. Die Ernten reichlich, die Menschen konnten überwiegend gut leben.

Die große Frage ist. Wie haben es die Menschen geschafft im ausgehenden Mittelalter die Globaltemperatur zu beinflussen. Durch das CO2 ihrer Kamine, ihrer Lagerfeuer? Industrie und Verkehr in heutiger technologischer Ausprägung und Menge gab es ja noch nicht. Es war doch so schön alles im Einklang mit der Natur. Ein großes Rätsel, zu dem das IPCC bisher keine so richtigen Erklärung fand.

Um das Jahr 1900 begann dann ein Verlauf wie er detaillierter und überlagert mit dem „errechneten“ CO2 Verlauf in der folgenden Grafik gezeigt wird.

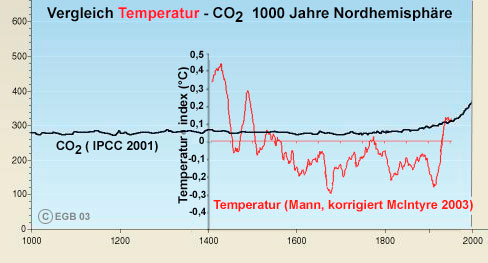

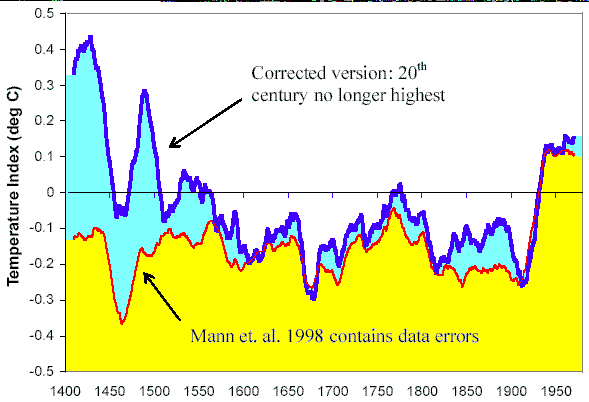

Dort sehen wir den vom IPCC 2001 im 3. Assessment-Report herausgegebenen Wert der CO2 Kurve überlagert vom (korrigierten) Temperaturverlauf den in seinem Originalverlauf ein Dr. Mann 1998 errechnet hatte, die so genannte „Hockeystickkurve”.

Die, weil sie z.B. die mittelalterliche Wärmeperiode nicht zeigte, von den kanadischen Wissenschaftlern Stephen McIntyre & Ross McKitrick kurze Zeit später und gegen viele Widerstände, korrigiert wurde. Gezeigt wird hier die korrigierte Kurve der beiden. Diese „Hockeystickkurve“

hat eine eigene denkwürdige Geschichte, die ich den Lesern nicht vorenthalten will. Aber zuerst gucken wir uns mal den Verlauf der beiden Kurven an. Wir sehen starke Schwankungen der Temperatur, aber so gut wie keine

Schwankungen des CO2 Anteiles der Atmosphäre. In keiner erkennbaren Weise verknüpft oder eng korreliert mit dem Temperaturverlauf.

Nur im letzten Rest, so gegen 1920 steigt die Temperatur an (es wirkt stärker weil, durch den Maßstab verzerrt) dto. der CO2 Anteil. Sollte plötzlich die Physik Kapriolen schlagen und CO2 auf die Temperatur heftig wirken lassen, oder war es vielleicht umgekehrt?

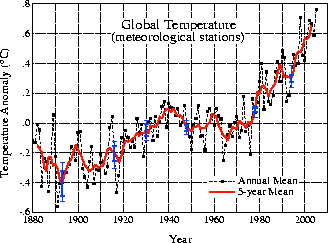

Ich komme noch darauf zurück, aber zuerst wollen wir die bodennahe Temperaturentwicklung bis zur Gegenwart verfolgen. Das Goddard Institute (GISS) in den USA hat diese Werte ermittelt, wie gesagt auf Basis der bodennahen ungenauen und unzuverlässigen Meßstationen.

Wir sehen dort einen Abfall ab 1880 dann einen recht starken Anstieg bis 1940 dann wieder einen Abfall bis 1976 (obwohl in diesem Zeitraum die CO2 Emissionen um 400 % anstiegen!) und von dort einen Anstieg bis 1998, dem Jahr mit der höchsten Spitze bedingt durch die El Niño Kapriolen und weiter bis 2005. (Dieser Abfall bis 1976 veranlaßte übrigens damals, den immer noch berühmten IPCC Forscher Prof. Stephen Schneider eine fürchterliche

Eiszeit ab 2000 vorher zu sagen, heute prognostiziert er und mit ihm die UN eine mindestens so fürchterliche Warmzeit )

Wie stark die Ungenauigkeiten der zusammengefaßten Trendmeldungen sich auswirken können zeigt die Kurve der Temperaturentwicklung nur für die USA, wo hunderte von präzise gewarteten Wetterstationen über das 20.te Jahrhundert die folgenden Werte zeigte:

Man sieht viel, nur keine bedrohliche Erwärmung, (außer der El Niño Spitze 1998) vor der inzwischen auch -Al Gore sei Dank- die Amerikaner soviel Angst haben, wie wir. Beide Grafiken wurden vom GISS in Zusammenarbeit mit der NASA produziert).

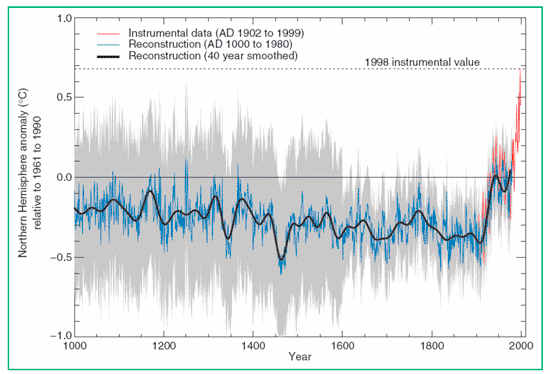

Die Hockeystickkurve

Nun – wie versprochen- die Geschichte der Mann´schen Hockeystickkurve. Der amerikanische Wissenschafter Dr. Mann und die Seinen untersuchten 1998 die Baumringe -überwiegend nordamerikanischer- Nadelbäume und leiteten aus ihnen ein Rechnermodell ab, das den folgenden Verlauf der Temperatur der nördlichen Hemisphäre errechnete: Es entstand eine wunderbare Temperaturkurve ab dem Jahre 1000, die den erschröcklichen Anstieg zur Mitte des 20. Jahrhunderts zeigte: und das war genau das, was die leitenden Herren des IPCC haben wollten.

Diese Kurve, 1998 berechnet, fand sofort und an prominenter Stelle Einlaß in den IPCC Bericht von 2001, wurde zigmal dort zitiert und nahm seinen Siegeszug durch die mediale und politische Welt. Wunderbar, der Mensch und sein CO2 ist schuld, hier sieht man´s ja. Einsetzen der Industrialisierung und Anstieg der Global Temperatur gingen eng gekoppelt – nicht mehr nur korreliert – Hand in Hand. Die Champagnerkorken knallten beim IPCC.

Endlich hatte man was in der Hand, um den astronomischen Forderungen an die Kyotoländer Nachdruck zu verleihen. Hier war der Beweis. . Die Frage darf erlaubt sein: Ließen sich deshalb prominente Vertreter des IPCC

– allen voran Sir Houghton – mit dieser Kurve im Hintergrund interviewen? Sie hatte allerdings einige Schönheitsfehler. Als Stephen McIntyre & Ross McKitrick und andere – darunter Hans von Storch in Deutschland – einen zweiten Blick auf diese Kurve warfen, fiel ihnen auf, daß die ganze schöne, mittelalterliche Warmzeit schlicht nicht vorhanden war. Obwohl sie – weil gut dokumentiert – einwandfrei nachweisbar war. Auch die dann folgende -noch besser dokumentierte- kleine Eiszeit war nicht so recht erkennbar. Den IPCC Oberen war das irgendwann auch aufgefallen. Statt jedoch zuzugeben, daß ihre so schöne Grafik, schwere Fehler enthielt, versuchten sie zu verhindern, daß die Kurve offiziell korrigiert wurde. Ein mit dieser Aufgabe befaßter IPCC Wissenschaftler faßte diese Versuche in der Bemerkung zusammen: „We have to get rid of this medievial warm up period“: in gut Deutsch: „Wir müssen irgendwie diese mittelalterliche Warmzeit loswerden“ Diese Bemerkung

wurde 2004 gegenüber Dr. Deming -einem amerikanischen Palaeoklimatologen gemacht- weil dieser fälschlicherweise vom IPCC Mann als Gesinnungsgenosse eingestuft wurde. Er hat sie überliefert.

Stephen McIntyre & Ross McKitrick versuchten nun das Computer – Modell nachzubauen (die Zusammenarbeit mit Dr. Mann war nicht sehr ergiebig) schaffte es aber dann doch und fütterte dieses Computerspiel nun mit

allen möglichen Daten, auch den Originaldaten des Dr. Mann. Zuletzt und viele 10.000 Durchläufe später einfach mit Zufallszahlen. Und heraus kam – o Wunder- immer und immer ein Hockeystick. Das Modell konnte

gar nicht anders. Es war auf diesen Schlenker hin programmiert.5

Die UN und alle ihr folgenden Regierungen und NGO´s oder GO´s haben sich übrigens bis heute nicht für diesen bewußte Irreführung

entschuldigt. Man kann sich ja mal irren, nicht wahr. Übrigens hatte sich die gesamte wissenschaftliche Fachpresse – auf wessen Druck wohl- geweigert diese Korrekturen öffentlich zu machen. Ein Schelm der Schlechtes

dabei denkt. Die dann ordentlich überarbeitete Hockeystickkurve6 finden Sie hier noch einmal schön mit der IPCC –Kurve übereinander gelegt.

Erdtemperaturverlauf bis Ende 2005

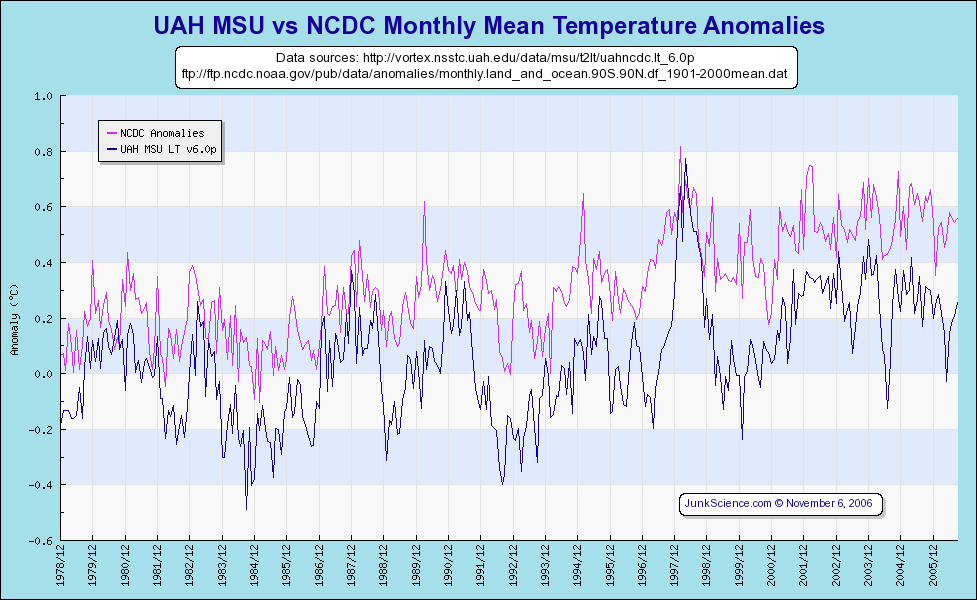

Nun zur meßtechnischen Neuzeit. Die Temperaturentwicklung im Satellitenzeitalter: (Sie finden die Messungen der NASA und des GISS unter Angabe der Quellen in unten stehender Grafik)

Sie zeigt den aktuellsten Temperaturverlauf der Erde, von 1979 bis Ende 2005, wie er von div. Instituten im offiziellen Auftrag und mit verschiedenen Methoden gemessen wurde.

„NCDC (lila gefärbt) Anomalies“ sind Temperaturen der terrestrischen Stationen, deren Zahl seit 1970 von ca. 5000 auf jetzt nur noch 2000(!) weltweit zurückgegangen sind. Sie befinden sich meist in oder in der Nähe von urbanen Zentren und zeigen als solche – u.a. durch den Wärmeinseleffekt- starke Abweichungen von den Meßreihen, die in unberührter Natur z.B. Arktis oder Antarktis, Tundra etc. durchgeführt werden. Das Problem: Korrekturen sind zwar möglich, aber nicht standardisierbar, da fast jede Meßreihe jeder Meßstation anderen Einflüsse unterliegt. Im Grunde sind diese Messungen, für den o.a Zweck, also mit ihnen die Erderwärmung zu messen, nutzlos. „UAH“ Messungen (blau gefärbt) sind solche mit Satelliten, die seit 1979 die Erde umrunden und eine sehr genaue Messung der durchschnittlichen Erwärmung erlauben. Sie zeigen sehr starke Abweichungen zu den terrestrischen Messungen. Nicht gezeigt sind die Wetterballonmessungen, die sich in sehr guter Übereinstimmung mit den Satellitenmes-sungen befinden. Näheres hierzu:

unter http://www.john-daly.com/ges/surftmp/surftemp.htm.

Wie man sieht, steigt die gemessene Oberflächentemperatur aus den bekannten Gründen deutlich stärker an, als es die Satelliten zeigen. Sie wird daher in fast allen Veröffentlichungen der Medien benutzt. Die Satelliten und Ballonmessungen steigen deutlich weniger an und auch nur bis zum Jahre 1998, dann setzt ein leichter Abfall ein, oder auch ein flacher Verlauf, so genau weiß man das noch nicht, aber kaum ein weiterer Anstieg.

Es wäre aber unredlich daraus schon einen Trend abzuleiten, aber wahrnehmen kann man ihn – auch im Hinblick auf Nairobi- schon.

Mein Fazit: Es gibt Erhöhungen der Globaltemperatur im 1/10 Grad Bereich seit Ausgang des 19. Jahrhunderts (ca. 0,6 ± 0,2 °C sagt das IPCC), davon ein großer Anteil vor 1940, als die CO2 Produktion der Industrienationen kaum begonnen hatte). Sie liegen – mit Blick auf die mittelalterliche Warmzeit- innerhalb der natürlichen

Schwankungen. Ein geringer Einfluß des Menschen ist vielleicht trotzdem anzunehmen. Irgendetwas Bleibendes müssen wir doch hinterlassen. Aber sie rechtfertigt weder ein Kyotoprotoll noch andere Enteignungs- und

Zwangsmaßnahmen, wie sie die Glaubensgemeinde der 6000 Erleuchteten in Nairobi derzeit vorbereitet.

Kapitel 2

Ist der CO2 – Anstieg der in der Atmosphäre seit ca. 100 Jahren zu beobachten ist, die wesentliche Ursache dafür? Und wenn ja, hat der Mensch mit seiner technischen

CO2 Erzeugung daran einen maßgeblichen Anteil?

CO2 ist als sog. Spurengas mit ca. 0,038 Prozent Anteil am Volumen (oder 380 p(art) p(er) m(illion)) in trockener

Luft enthalten. Dieses Schicksal als Spurengas teilt es mit anderen Spurengasen wie Methan (CH4), Ozon etc. Der große Rest trockener Luft besteht aus Stickstoff (ca. 78%) Sauerstoff (ca. 21%) und Argon (0,9%). Der stark

wetterbestimmende Wasserdampf ist zwischen 0 und 4 %– im Mittel mit 2%- in der dann feuchten Luft enthalten.

Diese geringe Menge CO2 macht nun so viel Wirbel, und wird zum allerschlimmsten Killer der Menschheit ausgerufen. Was tut dieses böse CO2 denn so Schlimmes? Es treibt die Temperatur der Erde hoch, ist die inzwischen von allen Politikern und Medien ständig wiederholte Ansage, darunter müssen ganz schrecklich viele Menschen leiden, jetzt schon und in naher Zukunft noch viel mehr. Und – noch viel Schlimmer- wir im Westen sind daran schuld. Die bösen Industrienationen. Pfui Teufel.

Da sollte sich doch jeder Mitbürger der einigermaßen klar im Kopf ist und eine VorPisa-Bildung genossen hat fragen: Ja, stimmt denn das? Einig sind sich alle Wissenschaftler, daß der Anteil von CO2 an der Atmosphäre seit einiger Zeit angestiegen ist. Von 2807 ppm auf ca. 380 ppm z.Zt. Unstrittig ist auch, daß dieser Anstieg mit der Industrialisierung einher ging. Also korreliert ist, wie man es auch vornehm ausdrücken kann. Korrelation bedeutet nun aber nicht, daß die korrelierten Prozesse voneinander abhängen. Sie können, aber sie müssen nicht8. Gar nicht unstrittig ist, woher dieser Anstieg rührt. Überwiegend oder ganz aus den Aktivitäten des Menschen bei der Verbrennung fossiler Brennstoffe, wie es uns die Grünen und inzwischen die ganze politische Klasse immer wieder vorwirft. Oder hat der Anstieg überwiegend oder ganz, natürliche Ursachen? Auch dafür sprechen sehr gute Argumente.

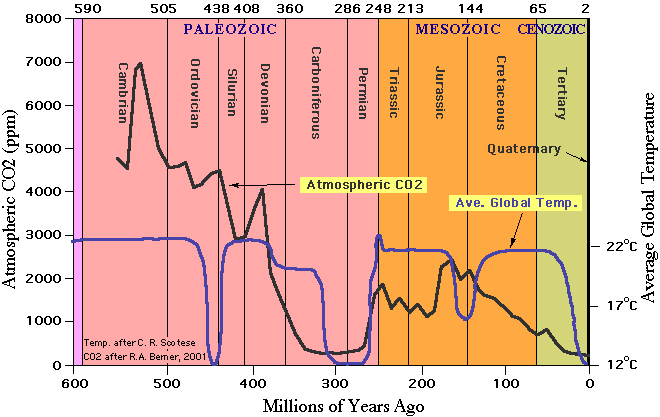

Welche Kapriolen das CO2 mit und ohne korrelierte Temperatur in der Erdvergangenheit geschlagen hat zeigt uns die folgende Grafik:

Erst die Erwärmung, dann die CO2 Konzentration

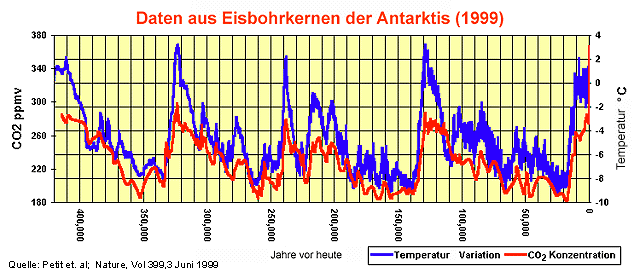

Einige davon sehen wir auch in der untenstehenden Grafik,

die den Temperaturverlauf und die CO2 Schwankungen in der Antarktis der letzten 420.000 Jahre darstellt, wie er aus Eisbohrkernen aus der Antarktis – wenn auch recht grob- hergeleitet werden kann. Wir erkennen sofort,

daß der CO2 Anteil periodisch schwankt und mit ihm die Temperatur. Bei genauem Hinsehen erkennen wir aber auch, daß erst die Temperatur ansteigt und dann das CO2. Dieser Abstand liegt je nach betrachtetem Abschnitt zwischen 500 und 1500 Jahren9

Mit anderen Worten: Erst kommt die Temperatur, dann das CO2. Jeder, der mal eine Flasche Bier einige Zeit in der Sonne stehen ließ, kann bestätigen, da ist was dran. Wärme treibt gelöstes CO2 aus dem Wasser heraus und wohin, in die Atmosphäre.

Nun kann man auf Grund dieser Grafik leicht zu dem Schluß kommen: Ja, der Zyklus -erst Temperatur dann CO2 Anstieg- mag ja sein, aber was ist mit dem absoluten Werten des CO2. So hoch wie heute waren sie ja wohl die letzten 420.000 Jahre nicht. So dachten bis vor kurzem auch alle, aber heute nur noch diejenigen die partout keine aktuellen Erkenntnisse zulassen, die ihrer Meinung entgegenstehen.

(Folgendes Zitate sind entnommen einer Arbeit von A. von Alvensleben, der diese Informationen an Prof. Rahmstorf im Rahmen einer Erwiderung von Vorwürfen erarbeitet hat):

„Die Messungen des CO2 -Gehalts in Eisbohrkernen haben sich, wie man erst seit wenigen Jahren weiß, doch als ziemlich ungenau erwiesen – wohl als Folge von Diffusionseffekten im Eis, durch die größere Schwankungen des CO2 -Gehaltes nivelliert wurden. Daher ist zur Zeit noch die Meinung verbreitet, in den letzten 420 000 Jahren habe der CO2 -Gehalt nur zwischen 190 ppm in den kältesten Zeiten und 280 ppm in den Warmzeiten gependelt. Daraus haben Botaniker gefolgert, der Anstieg des CO2 in der Atmosphäre um rund 30% in den letzten 140 Jahren sei in der jüngeren Erdgeschichte ein einzigartiger Vorgang, und die Natur werde sich darauf nicht einstellen

können, mit katastrophalen Folgen für die Pflanzenvielfalt.. Obwohl die Eisbohrkerne dies nicht erkennen lassen, zeigt das neue Meßverfahren, wie die atmosphärische CO2 -Konzentration von 260 ppm am Ende der letzten Eiszeit schnell auf 335 ppm im Preboreal (vor 11500 Jahren) anstieg, dann wieder auf 300 ppm abfiel und vor 9300 Jahren 365 ppm erreichte 10..“ Zitat Ende.

Nach soviel Naturwissenschaft wollen wir mal ein wenig zusammenfassen:

1. Die Konzentration von CO2 steigt und fällt in der Atmosphäre im Wesentlichen aus natürlichen Ursachen.

2. Die Konzentration von CO2 lag in den vergangenen 10.000 Jahren schon mal bei 365 ppm, evtl sogar darüber. Davor sogar noch wesentlich höher. (siehe Grafik weiter unten)

3. Die Konzentrationszu- oder abnahme von CO2 folgt dem Temperaturverlauf mit einer Verzögerung zwischen 500 bis 1500 Jahren.Die ursachen dafür können immer noch nur vermutet werden.

Des ungeachtet muß erwähnt werden, daß die menschliche Aktivität ebenfalls – jedenfalls einigermaßen

wahrscheinlich- zum Anstieg der CO2 Konzentration beiträgt. Aber wieviel und mit welchen Wirkungen, das ist schlicht nicht genau bekannt. Es könnte ja gut sein, daß der einzige wirklich nachgewiesene Treibhauseffekt des CO2, nämlich das Pflanzenwachstum zu beschleunigen (ich komme weiter unten noch ausführlicher darauf) das zusätzlich entstehende CO2 schlicht absorbiert. Wir wissen es nicht. Es gibt zwar interessante Hypothesen, aber keine wirklichen Beweise s.o.

Kann CO2 das Treibhausgas sein, welches die Globaltemperatur nach oben treibt?

Wie ist es nun mit der These, daß CO2 das Treibhausgas ist, welches die Globaltemperatur nach oben treibt. Sehr viele Untersuchungen wurden angestellt und alle möglichen physikalischen und chemischen Effekte

in der Atmosphäre wurden untersucht. Immerhin fließen jährlich ca. 8 Mrd $ in diese Forschung, davon 4 Mrd in die USA und den weitaus größten Teil der zweiten Hälfte erbringt die EU. Danach wirkt das CO2 hauptsächlich über seine Abstrahlung (Strahlungsantrieb) aufgenommener Energie, das ist überwiegend Energie direkt von der Sonne.

Das IPCC schätzte 2001 den für die Wirkung entscheidenden Wert der Klimasensitivität CS11 – auf Grund von Modellrechnungen und Datenbankanalysen- auf ca. 2,8° C, Prof. Stephen Schneider -einer der führenden US – Klimaforscher und häufiger Katastrophenmahner, Mitglied in div. Forschungsgremien, so auch dem IPCC- konstatierte noch im Oktober 2000 ganz ehrlich: „Die Klimasensitivität (CS) der Erde für CO2 sei unbekannt, es werde jedoch für Simulationsrechnungen angenommen, daß der wahrscheinlichste (Gleichgewichts-)wert CS für eine CO2 Verdoppelung zwischen 1,5 und 4,5 ° C liegt“. Na, wenn das keine klare Ansage ist. Unbekannt, aber wir schätzen eben mal einen Wert für unsere Modelle irgendetwas zwischen 1,5 und 4,5 ° C. Andere Forscher haben nicht nur Modellrechnungen (Dietze, Barett u.a.) sondern aus den gemessenen Verläufen Regressionsanalysen12 gemacht. Daraus ergibt sich dieser Wert mit ca. 0,7° C. Also eine Verdoppelung des CO2 Anteiles (bei sonst unveränderten sonstigen Werten z.B. der Sonneneinstrahlung), ergibt – als Korrelation!- eine Erhöhung

der Temperatur um schlappe 0,7 °. Das ist ein Viertel des IPCC Wertes. Sechs schöne und übeberaus plausible Methoden den CS-Wert aus realen Meßdaten zu ermitteln, finden sich hier:http://www.john-daly.com/miniwarm.htm Sie haben aber – aus Sicht des IPCC- einen gewaltigen Schönheitsfehler, sie ergeben nur CS-Werte zwischen 0,17°C bis 0,33°C. Wahrscheinlich ist das der Hauptgrund, warum das IPCC sie verschmäht.

Sie passen so garnicht in die Mär von der menschengemachten Erderwärmung.

Das IPCC bereitet z.Zt. seinen 4. Bericht vor darin soll wieder ein höherer CS-Wert genannt werden. Wie auch anders, daß Bedrohungsscenario gilt es aufrecht zu halten.

Wir haben aber keine Verdoppelung des CO2 bisher erlebt, sondern einen Anstieg um 20 bis 30 % je nach dem auf welchen Eingangswert man sich bezieht. Die Untersuchungen von P. Dietze – offizieller Berichterstatter des IPCC – deckten des weiteren erhebliche Parameterfehler in den IPCC-Modellen auf, die bis 2100 insgesamt zu einer Überschätzung der CO2 – bedingten Erwärmung um etwa 600% führen. Man stelle sich vor 600 % zu viel!

Führende IPCC Forscher wie Prof. Lennart Bengtsson et al. vom Klimarechenzentrum Hamburg gaben13 sogar

zu, daß die Erwärmung weit geringer ausfällt und langsamer erfolgt, als bisher berechnet wurde. Hinsichtlich der Übertreibung der Klimaerwärmung sei auch an Prof. Stephen Schneider mit seiner bekannten Aussage von 1989 erinnert „To capture the public imagination, we have to offer up some scary scenarios, make simplified dramatic statements and little mention of any doubts one might have.

Each of us has to decide the right balance between being effective, and being honest“14 Auf gut Deutsch: „Um Aufmerksamkeit zu erregen, brauchen wir dramatische Statements und keine Zweifel am Gesagten, jeder von uns (Forschern) muß entscheiden wie weit er eher ehrlich oder eher effektiv sein will“ Wir haben jedenfalls sehr effektive Forscher auf diesem Feld, ansonsten kein weiterer Kommentar nötig.

Außerdem geht das IPCC von einem progressiven Anstieg des weiteren CO2 Gehaltes der Atmosphäre aus, die anderen und das deckt sich mit den Messungen, aber nur von einem linearen Anstieg. Zitat dazu von Juri Israel (Direktor des Instituts für Weltklima und Ökologie der Russischen Akademie der Wissenschaften, IPCC-Vizepräsident: „Viele Wissenschaftler sprechen von einem CO2 -Anteil in der Atmosphäre von 400 ppm als dem Grenzwert. Unsere Berechnungen ergaben: Selbst wenn die gesamten erkundeten und gewonnenen Kraftstoffe der Erde im Laufe von wenigen Stunden verbrannt würden, stiege die CO2 -Konzentration lediglich auf 800 ppm. Aber unsere Erde erlebte in ihrer Geschichte 6000 ppm, nämlich im Karbon, und das Leben, wie wir sehen, geht weiter.„

Ein linearer Anstieg würde – vorausgesetzt alles andere bliebe so wie es jetzt ist- zu einer Erhöhung der Temperatur um nur 0,24 ° C (bedingt durch den CO2 Anteil) bis 2100 führen, bezogen auf heute. Gleichzeitig würde das CO2 nicht über 470 ppm steigen können, schlicht aus Verfügbarkeits- und Preisgründen. Die fossilen Brennstoffe würden sich so verteuern, daß man es sich nicht mehr leisten kann sie zu verbrennen.

Gibt es bei diesen Werten genügend Gründe aktiv zu werden? Ja, es gibt welche! Und das sind (durch Angstmache von uns) erpreßte Steuern und Abgaben! Das haben die Bürokratien der Welt, die politische Klasse und mit einiger Verzögerung, auch die Wirtschaft erkannt. Ich werde darauf zurückkommen. Übrigens, mal etwas zur Verhältnismäßigkeit: rechnet man 4 Menschen auf den m2 wie im Fahrstuhl, dann paßt die gesamte Menschheit auf die Fläche des Saarlandes, und es ist immer noch nur zu 60 % belegt.

Das Saarland seinerseits paßt knapp 200.000 mal in die Oberfläche der Welt und immerhin noch gut 32.000 mal in die bebaubare Fläche der Erde.

Kapitel 3

Ist dieser Klimawandel insgesamt schädlich oder eher nützlich?

Pflanzenwachstum

Die Fragestellung nach der Wirkung des CO2 wäre unvollständig behandelt, wenn man nicht auch die anderen Wirkungen die ein CO2 Anstieg mit sich bringt, betrachtet. Wikipedia15 schreibt über CO2 u.a.„….Pflanzen benötigen das in der Luft enthaltene Kohlenstoffdioxid zur Photosynthese. Für fast alle Pflanzen ist dies die einzige

Kohlenstoffquelle..“ Zitatende. Der eigentliche wirklich sicher meßbare Treibhauseffekt des CO2 liegt in einem beschleunigten Pflanzenwachstum (s.Idso). Kein Zweifel, die Welternährung wurde drastisch und ohne Zutun des Menschen gesteigert. Das Center for the Study of Carbon Dioxide and Global Change stellt dazu vor kurzem fest: Zitat: „Was haben diese zusätzlichen 100 ppm uns in Form erhöhter landwirtschaftlicher Produktivität gebracht?

In unserem Redaktionsbeitrag vom 11. Juli 2001 haben wir experimentelle Arbeiten beschrieben, die auf Studien von Mayeux et. al. (1997) und von Idso und Idso (2000) beruhten. Aus ihnen lässt sich ableiten, dass der Luftdüngungseffekt zu folgenden mittleren Ertragssteigerungen geführt hat: 70% für C3-Getreide, 28% für C4-Getreide, 33% für Obst und Melonen, 62% für Hülsenfrüchte, 67% für Wurzel- und Knollengewächse

und 51% für Gemüse.” Der Autor fährt dann fort: “Dieser historische CO2-induzierte Erntezuwachs … war völlig ungeplant vom Menschen. Zitat Ende.

Na, ist das nichts? Und noch mehr dazu: Zitat aus der vorher zitierten Arbeit von. A. von Alvensleben:

Die positiven Wirkungen der CO2 -Vermehrung sind damit noch gar nicht alle aufgezählt: Mehr CO2 bedeutet meßbar geringeren Wasserbedarf der Pflanzen, also Erweiterung von Anbaumöglichkeiten in trockenere Gebiete hinein, und verlängerte Photosynthesezeiten in der Morgen- und Abenddämmerung (um Minuten) und im Frühjahr und Herbst (um Tage). Und zu den neuesten, noch nicht ganz gesicherten Ergebnissen gehört, daß vermehrtes CO2 auch als Heilmittel gegen das Waldsterben wirkt – den kranken Bäumen scheint die CO2 -Kur gut zu bekommen. Zitat Ende (Zum Glück für uns alle, hat sich das große Thema Waldsterben, wie so viele andere Themen wie z.B. auch die BSE-Krise, sang- und klanglos erledigt.)

Und das alles wollen wir behindern, vermeiden, vernichten. Ja, es darf sich jeder selbst seinen Reim drauf machen. Die Hoffnung stirbt zuletzt. Aber, so werden viele einwenden, was ist denn mit dem Schmelzen der Gletscher, des weltweiten Eises und des drohenden Anstiegs der Meeresspiegel.

Die Gletscher und das Eis

Es ist ganz klar, wenn es wärmer wird, schmilzt Eis. Seit dem Ende der kleinen Eiszeit schmelzen daher nicht nur die alpinen Gletscher, auch die Kilomandscharoeiskappe schmilzt, (wenn auch aus anderen Gründen). In Norwegen und anderen Weltgegenden wachsen sie hingegen. Es gibt derzeit KEINEN globalen Trend der Gletscherschmelze (R.J. Braithwaite 2002″ Glacier mass balance: the first 50 years of international monitoring“ (Progress in Physical Geography 26: 76-95).

Aber, selbst wenn alle Gletscher abschmelzen, ist das wegen der minimalen Eismasse belanglos. Eine aktuelle Übersicht über den Zustand (Massenbilanz) von 246 Gletscher von global 160 000 zwischen 1946 and 1995 hat

R.J. Braithwaite 2002 vorgestellt. Der Autor weist nach, daß es weltweit keinen Trend zum Abschmelzen der Gletscher gibt. Dagegen entwickeln sich die Gletscher lokal unterschiedlich. Innerhalb Europas schrumpfen die

alpinen Gletscher, die skandinavischen nehmen an Eismasse zu und die kaukasischen Gletscher sind stabil geblieben.

Tatsächlich wissen wir noch zu wenig über den aktuellen Zustand der Gletscher der gesamten Erde, da bisher von den ca. 160 000 Gletschern erst 67 000 (= 42%) bezüglich einer Massenbilanz untersucht wurden. Für ca. 200 wurde eine 1-jährige Massenbilanz erstellt und von 115 kennt man die Massenbilanz über 5 Jahre, von 79 die im Sommer und Winter Nur 42 Gletscher wurden so über 10 Jahre untersucht (0,026%!!!). http://www.egbeck.de/treibhaus/meers1.htm Ob dabei wieder alte Wikingersiedlungen zum Vorschein kommen, wird mit Spannung erwartet. Andererseits wächst die Eismasse in Mittelgrönland und auf der Antarktis16.

Der Meeresspiegel

Die schlechte Nachricht ist: Ja, der Meeresspiegel steigt. Und zwar seit dem Ende der letzten Eiszeit. Lag er doch vor knapp 10.000 Jahren, ca. 120 m unter dem jetzigen. Und dieser Prozeß ist nicht abgeschlossen. Seit dem Ende der kleinen Eiszeit um 1860 steigt der Meeresspiegel global um ca. 2,5 mm/Jahr. In den Zwanzigern, so wie in den Neunzigern17.

Weniger dramatisch sieht es im südlichen Pazifik aus. Glaubt man dem US Forscher Hansen (seine Aussage vor dem US Senat im Jahre 2000) dann wird der Meeresspiegel sich bis zum Jahre 2100 um mindestens 1 Meter erhöhen.

Das erkannte er aus seinen Modellen. Nur, der Meeresspiegel tut es nicht! Auch nicht in Tuvalu und anderen paradiesischen Gefilden. Es soll dort nun bald das Meer über den Köpfen der Tuvalesen (aber zumindest über

ihren Waden) zusammenschlagen, weil ihr Eiland nur wenige cm über dem Meeresspiegel liegt. Ganz Eifrige prüfen schon, ob sie nicht irgendwelche Regierungen auf Schadensersatz verklagen können, weil ja diese

am CO2 Anstieg schulde sind.. Leider – oder besser Gott sei Dank- sieht die Situation – ganz entspannt so aus: A.v. Alvensleben schreibt dazu in seiner sehr lesbaren Dokumentation18 über den Stand der Forschung über den Klimawandel: Zitat: „Pegelmessungen über 3 Jahrzehnte in Tuvalu, einem kleinen pazifischen Inselstaat, und in Diego Garcia, dem englischen Flottenstützpunkt mitten im Indischen Ozean, zeigten keine Veränderung

des Meeresspiegels. Lediglich von Zeit zu Zeit, wenn der Wind den El-Niño-Strom nach Osten trieb, sank der Meeresspiegel für einige Zeit um bis zu 30 cm, um anschließend zu normalen Werten zurückzukehren…..

Entsprechendes gilt für den Inselstaat der Malediven, deren Vertreter in Marrakesch auf die drohende Überflutung ihrer Inseln hingewiesen haben sollen. Eine schwedische Untersuchungskommission unter Leitung eines

führenden Experten für die Frage von Meeresspiegelschwankungen (Prof. Mörner) hat das Problem auf den Malediven untersucht und überhaupt keine Zunahme des Meeresspiegels für die letzten 100 Jahre gefunden.“ Zitatende. Also Panik absagen! Weitersagen!

Fassen wir noch mal zusammen:

1. Die Konzentration von CO2 steigt und fällt in der Atmosphäre im Wesentlichen aus natürlichen Ursachen.

2. Die Konzentration von CO2 lag in den vergangenen 10.000 Jahren schon mal bei 365 ppm.

3. Die Konzentrationszu- oder abnahme von CO2 folgt dem Temperaturverlauf mit einer Verzögerung zwischen 500 bis 1500 Jahren. Die Ursachen sind nicht erforscht.

4. Der CO2 Anstieg, mit einem nur unpräzise zu erfassenden Anstieg durch anthropogenes CO2 führt maximal – weil uns der Brennstoff bis dahin zu teuer würde ggf. sogar ausgegangen ist- zu einem Temperaturanstieg

von ca. 0,2 bis 0,3 ° C. bis zum Jahre 2100.

5. Der Anstieg der CO2 Konzentration bewirkt gleichzeitig eine weitere und dramatische Verbesserung der Welternährungslage, keine Veränderung des Anstiegs der Meeresspiegel und keine erkennbare Veränderung der Welteismassen..

Kapitel 4

Können wir, die Menschheit insgesamt, realistischerweise etwas dagegen tun?

Die erste Feststellung dazu muß lauten: warum sollten wir? Die Erwärmung ist in erster Linie natürlichen Ursprungs, dazu, in der Bilanz ergeben sich wesentlich bessere Lebensbedingungen für alle, als ohne diese Erwärmung. Selbst die Klimaforscher erleben einen Geldsegen, den sie ohne die Erwärmung, ehrlicherweise natürlich auch ohne ihre Panikmache, sonst nicht bekommen hätten. (Die Frage nach dem alten lateinischen Grundsatz: Cui Bono, Wem nützt es? ist hier sicher auch angebracht) .

Modellrechnungen des IPCC und anderen.

Aber das reicht den Verursachern und Aktivisten (s. Kapitel 5) nicht, sie wollen alles. Und dazu dienen auch die Modellrechnungen der UN (mit Zulieferung des IPCC, unter anderem auch des Max Plank Institutes für Meteorologie in Hamburg), der jetzt passend zu Nairobi veröffentlichte Sternreport und vieles andere mehr.

Schauen wir uns erst einmal die Güte dieser Modellrechnungen an. Man benötigt dazu nicht so viele Kenntnisse, es genügt, wenn man sich die Verlautbarungen und Erklärungen der Modellierer selbst anschaut. Zur Einstimmung noch mal dazu die Einschätzung von Kofi Annan in seiner Eröffnungsrede in Nairobi Zitat:“…Das ist nicht Science Fiction, das sind plausible Scenarios, basierend auf strenger, wissenschaftlicher Modellierung….. “ Zitatende. Nun, da hat wohl einer dem Secretary General einige dicke Bären aufgebunden, bzw. hat er sich gerne aufbinden lassen. Hier dazu die passenden Äußerungen der Modellierer, wie sie ihre Modellierungskünste selbst sehen: Das MPI Hamburg betont in einer Presseerklärung feinsinnig (auf die Pleite hin, die es kürzlich mit seiner Prognose des Wetters in 50 Jahren erlebte) Zitat “ Wir betonen stets den Szenariencharakter (unserer Modelle). Deshalb benutzen wir in diesem Zusammenhang immer den Konjunktiv. Wir sagen NICHT das Klima voraus, sondern geben Entwicklungsmöglichkeiten des Klimas für die Zukunft an. “ Zitatende. Das konnte meine Oma schon mit ihrem Rheumaknie, und der Kaffeesatz war auch nicht schlechter, nur viel, viel billiger.

Der kanadische Klimaforscher Prof. Dr. Tad Murry forderte kürzlich einen Journalisten auf, künftig „keine Ergebnisse meiner Computermodelle“ zu zitieren. Damit habe er Zitat „seit 45 Jahren zu tun und ich kann Ihnen damit beweisen, was immer Sie wollen. Wenn Sie wollen, kann ich eine weltweite Erwärmung herbeiführen, wenn Sie hingegen eine Eiszeit wollen, kann ich diese ebenfalls herstellen, mit einer sehr geringen Veränderung eines einzigen Modellparameters (die Anzahl der niedrig. Wolken).“ Zitatende..

Das frühere Mitglied des Umweltschutzverbandes Sierra Club und Geologe sowie Jurist Paul Driessen schreibt in seinem Buch: Öko-Imperialismus u.a. Zitat: “ Bezüglich der Computermodelle ist hinzuzufügen, daß sie klimatische oder atmosphärische Komplexitäten nicht einmal im Ansatz darstellen können. Noch schlimmer: Sie widersprechen gemessenen Temperaturdaten, können weder künftige Temperaturen vorhersagen, noch frühere Temperaturen rekonstruieren und produzieren haarsträubend widersprüchliche Vorhersagen für identische Regionen.

Das schlimmste: Sie schließen wahnwitzige(?) Annahmen über das künftige Wirtschaftswachstum und Emissionen ein. Ein Szenario der UNO sagt voraus, daß Lybien und Nordkorea am Ende dieses Jahrhunderts höhere

Pro-Kopf Einkommen haben werden, als die Vereinigten Staaten.“ Zitatende. Und: “Um zum Ergebnis einer Erwärmung von 1,4 bis 5,8 Grad in diesen Scenarien, die auch Sir Nicholas Stern benutzt, bis 2100 zu kommen, müssten sich beispielsweise die Einkommen in Asien versiebzig- bis verhundertvierzig-fachen. Ein solcher Einkommensanstieg wäre absolut beispiellos in der Geschichte. Zum Vergleich: im Verlauf des gesamten 20. Jahrhunderts haben sich die Einkommen in Japan nur knapp verzwanzigfacht. Selbst wenn man davon ausgeht, dass nur eine Erwärmung von 1,4 Grad bis 2100 stattfindet – also der untere Rand der Prognosebandbreite – impliziert das beispielsweise laut David Henderson, dass die Wirtschaftsleistung pro Kopf in Südafrika bis zum Jahr 2050 auf die doppelte Höhe der USA steigt.19

Die Modelle und die Annahmen auf denen sie basieren, stimmen hinten und vorne nicht, das kann jeder sehen20.

Weil aber auf jeden Falle etwas zur Klimahysterie am Ende passendes herauskommen soll, kommt keines dieser Modelle ohne „Fudge-Factor“ aus. Das heißt, es wird der Daumen auf den richtigen Teil der Waage gelegt,

bis es stimmt, oder anders ausgedrückt: Es wird betrogen und gelogen daß sich die Balken biegen.

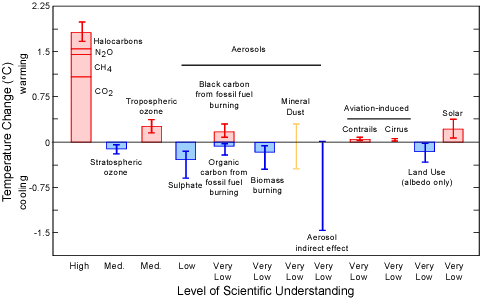

Und in der Frankfurter Allgemeinen Sonntagszeitung vom 30.4.2004; schreibt der Autor Stefan Dietrich Zitat: „Die Zusammenfassung für politische Entscheider (des IPCC)“ listet zwölf solcher Klima-„Antriebe“ auf und vermerk t jeweils, in welchem Maß ihre Wirkungsweise wissenschaftlich erforscht sei. Acht fallen in die niedrigste Kategorie „sehr geringes Wissen“. Mit Wissenschaftlern aber, die nichts Genaues wissen, können politische Entscheidungsträger ebenso wenig anfangen wie Journalisten.“ Zitatende.

Der bekannte Mathematiker und Chaosforscher Heinz-Otto Peitgen sagt zu diesem Thema Zitat: „Frage: Lässt sich denn das Klima modellieren?

Peitgen: Jetzt reden wir von Glaubenssachen. Es gibt Leute, die glauben – und viele von denen sitzen in hoch bezahlten Positionen in sehr bedeutenden Forschungszentren -, dass man das Klima modellieren kann. Ich zähle zu denen, die das nicht glauben. Ich halte es für möglich, dass sich die mittlere Erwärmung der Ozeane in 50 Jahren mit einem bestimmten Fehler vorausberechnen lässt. Aber welche Wirkungen das auf das Klima hat, das ist eine ganz andere Geschichte.“ Zitatende.

Hier die Grafik, wie das IPCC selbst sein Wissen um die klimabestimmenden Faktoren einschätzt:

Einfacher gesagt: GiGo – Garbage in, Garbage out; das ist ein geflügeltes Wort aus dem Computerbereich. Müll rein, Müll raus! Es spricht für sich selbst.

Jetzt macht das Eingangszitat des MPI in Hamburg sehr viel mehr Sinn, oder? Sie betreiben mit extrem teuren Computern, extrem teure Computerspiele. Und Kofi Annan läßt sich unterjubeln, daß dies Hardcore-Wissenschaft

sei. Sollen sie doch weiterspielen, aber bitte nicht, um uns mit ihren unausgegorenen Scenarien, die Medien und Politik begeistert in Vorhersagen umwandeln, in Panik zu versetzen.Wie weit dem IPCC mit seinen Prognosen zu trauen ist, zeigt die Entwicklung seiner Voraussagen je nachdem zu welchem Zeitpunkt gerade abgefragt wird. Wie wir sehen, werden wir bald um Null landen.

|

Jahr des IPCC Berichtes |

1988 |

1990 |

1995 |

2001 |

|

Erwärmung/Dekade |

0,8°C |

0,3°C |

0,2°C |

0,1°C |

|

Temperaturanstieg bis 2030 |

3,0°C |

1,2°C |

0,8°C |

0,6°C |

|

Anstieg Meeresspiegel in cm |

20-150 |

15-40 |

5-35 |

10-20 |

Warum wird es trotzdem geglaubt? Das muß sich wohl jeder selbst fragen. Computern glaubt man eben. Computer sind die Kristallkugeln von heute. Am meisten aber müssen sich dies die Medien fragen, die tagtäglich diesen Unsinn verbreiten.

Fassen wir auch den Sachstand zu den Modellen des IPCC zusammen:

1. Es gibt keinen vernünftigen Grund zur CO2 Vermeidung außer den, knappe Resourcen sparsam einzusetzen. Eine solche Sparsamkeit erzwingt aber der Markt, knappe gefragte Güter werden teurer.

2. Die Modelle des IPCC basieren auf falschen, unverstandenen und nur in wenigen Fällen (3 von 12!) auf wissenschaftlich gefestigten Annahmen. Sie sind deshalb

schon vom Ansatz für Prognosen des künftigen Klimas und noch mehr, der wirtschaftlichen Folgen, unbrauchbar.

3. Die Ergebnisse der Modellberechnungen liegen haarsträubend daneben, sowohl was das Klima als auch die zu Grunde liegenden Wachstumsraten

der einzelnen Länder anbelangt.

4. Seriöse Wissenschaftler und Ökonomen lehnen die Ergebnisse als Unsinn oder (Aber-)Glauben ab.

5. Das IPCC selber senkt seine Prognosen laufend ab, aber erst dann, wenn sie durch die Realität eingeholt werden.

Kapitel 5

Kosten und Nutzen, oder warum geht es uns direkt an?

Nun noch ein paar Worte zu den Kosten die dieser Massenwahn uns allen auferlegt. Das Kyoto nichts aber auch gar nichts bringt, außer Kosten, pfeifen inzwischen die Spatzen von den Dächern. Da sind sich sogar Klimaschützer und Klimaskeptiker einig. Der Temperaturanstieg bis 2050 wird gerademal um 2/100 °C abgebremst21.

(Tritt dann aber 6 Jahre später doch ein, wie Lomborg nachwies) Aber es kostet, und wie! Das Bundeswirtschaftsministerium gab 200222 an: Für die Volkswirtschaft der Bundesrepublik sind es bis 2020 ca. 250 Mrd Euro. Ich behaupte: echte, ehrliche Kostenschätzungen kamen von diesen Leuten noch nie. Man kann getrost vom Doppelten ausgehen. Allein 2 Mrd Euro jährlich steckt Deutschland lt. Staatssekretär Würmeling23 in die Klimaforschung. Ein Geldsegen, den es zu erhalten gilt. Das sehen inzwischen auch die Liberalen in der FDP und

in der Wirtschaft so. Es ist leicht verdientes Geld und obendrein gibt es den Segen der öffentlichen Tugendwächter a la Greenpeace. Ein Berater der FDP MdB`s schrieb dazu sinngemäß: „Ja, was wollen Sie denn, wenn wir uns geirrt haben, dann ist das Geld doch nicht verloren, nur auf andere Bereiche umgelenkt. Opportunitätskosten nennt man das in der Volkswirtschaft“. Dieser Mann blieb aber die Antwort auf die Frage schuldig, wessen Geld er dann so opportunistisch umlenkt, seins oder das der Bürger. Und, ob wir nicht alle einen Anspruch auf größtmögliche

Effizienz beim Einsatz unserer Steuergelder haben. Und nicht auf pure Verschwendung zum Nutzen weniger und zu Lasten aller. Wie gesagt, darauf mochte er nicht antworten. Mich erinnert diese Antwort an den alten Börsenspruch

unter Bankiers nach einem Börsenkrach: „Was wollen Sie denn, das Geld ist doch nicht verloren, es hat nur ein anderer“. So ist es! Und das ist noch längst nicht alles. Nicht von ungefähr hat Gordon Brown – designierter Nachfolger von Tony Blair den von ihm in Auftrag gegebenen Sternreport in die Öffentlichkeit gebracht. Just vor Nairobi und just vor der Notwendigkeit – aus seiner Sicht- die Steuerschraube in Großbritannien kräftig anzuziehen. Zur Unterstüzung seiner Ansichten konzentrierte sich Sir Nicholas, auf die Verurteilung des freien Marktes (er ist in seinen Augen schuld am ungebremsten CO2 Ausstoß) und auf die seiner Meinung nach sinnvollste Maßnahme zu Bekämpfung des CO2 Ausstoßes, die Rationierung Eine typische sozialistische Errungenschaft. Wir haben es in Europa doch schon erlebt. Was zieht Sir Nicolas da vom Leder, mit welch irren Summen24

wirft er da um sich. Summen, die, wenn wir sie denn per Steuern und Umverteilung über die Bürokratie aufbringen, zu einer Begrenzung der Erwärmung von 2 ° C führen. Wir hätten dann das Glück, das wir nicht unter 4-5 ° C leiden müßten. Wenn wir aber nichts tun, so Sir Nicholas, dann würden wir schon 2035 die 2° C Marke übersteigen. Leider vergaß der Weltbankökonom in seiner Einleitung zu sagen, auf welchen Startwert sich diese 2° C beziehen. Christopher Monckton fand es heraus und veröffentlichte dies im englischen Telegraph25

am 12.11.06. Irgendwo im 700 Seiten langen Bericht des Sir Nicholas, lag die Bezugszeit und die Bezugstemperatur versteckt. Sir Nicholas bezog sich auf das Jahr 1750, einer Zeit also, von der die globale Temperatur nur aus

groben Schätzungen und durch wenige lokale Beschreibungen bekannt ist. Aus heutiger Sicht wären das, unter den schlimmsten Umständen ca. +0.7 ° C, bei einer CO2 -Konzentration von 485 ppm. Die IPCC – inzwischen vorsichtiger geworden, geht von + 0,3 ° C aus, bei 435 ppm. Diese präzisen Angaben basieren alle auf äßerst

ungenauen Schätzungen. Sie gaukeln deshalb eine Genauigkeit vor, die sie nicht haben können:Was davon zu halten ist, haben wir ausführlich im Kapitel 2 gesehen. Wir müßten zu diesem Zeitpunkt, also 2035, etwa den größten Teil der bekannten fossilen Brennstoffe verheizt haben. Südafrika wäre im Begriff die USA beim pro Kopf-Einkommen zu überholen und Nordkorea und Lybien sind auf dem besten Wege dazu. Natürlich ging Sir Nicholas, wenn schon denn schon, vom schlimmsten Wert aus, der im kommenden IPCC Bericht als Scenarium vorgestellt wird. Wir kennen das vom deutschen Panzergeneral des 2. Weltkrieges Guderian.

Von dem stammt -der aus seiner Sicht- nur konsequente Spruch: Nicht kleckern, klotzen!. Zu Befehl Sir Nicholas! Übrigens wurde Sir Nicholas von seinem Auftraggeber Gordon Brown kurz nach Veröffentlichung seines Reports

aus dem engsten Kreise gefeuert. Hatte er zuviel geflunkert, hatte er zu wenig geflunkert? Wir wissen es nicht, nur daß der ganze Bericht ein einzige Flunkerei ist, das wissen wir. Na ja, was wir von Computermodellen

und ihren Scenarien zuhalten haben, hatten wir schon beleuchtet.

Kapitel 6

Wie konnte es zu dieser weltweiten Hysterie kommen?

Einige Motive und Aktionen der Klimakatastrophiker in Wissenschaft, Medien und Politik

Wenn man das obige alles unvoreingenommen liest, dann dürfte der erste Eindruck sein. Dieser Mann, der Autor, hat sie nicht mehr alle. Das kann doch gar nicht wahr sein.

Warum sollen denn alle die honorigen Forscher und sonstigen Offiziellen so lügen? So eine Riesenverschwörung gibt es doch nicht.

Nein, die gibt es nicht, aber was es gibt, ist eine künstlich erzeugte und am Kochen gehaltene Massenpsychose. Am Kochen gehalten von Sozialisten der ersten Stunde und Gutmenschen, die zurück zur Natur wollen und all jenen die gemerkt haben, daß damit schnell viel gutes Geld einfach zu verdienen ist. Was es gibt, sind schnöde Motive vieler unserer Wissenschaftler („dienende Forscher“ wie sie Dr. Hartkopf Staatssekretär und UBA Gründer seinerzeit treffend genannt hat) und Offizielle, zunehmend auch Wirtschaftsbosse, die sofort erkannt haben, daß sich mit diesem Megathema wunderbar riesige Bürokratien aufbauen lassen, Steuermittel in Milliardenhöhe gerne genommen und gegeben werden und sich die Macht, der Einfluß und die Reputation auf einfache Weise steigern läßt. Viel leichter als auf ehrliche Weise! Wenn mühsam für Steuern und Abgaben geworben werden muß, wenn knappe Forschungsmittel im Wettbewerb eingeworben werden müssen, ohne diesen Angstaspekt. Wenn man obendrein noch, bei normaler Ausübung seiner Geschäfte von sog. NGO´s den unkontrollierbaren, völlig intransparenten Organisationen vieler idealistisch denkender Menschen, als Umweltverschmutzer, gar Umweltverbrecher, beschimpft oder gar boykottiert wird. Wer erinnert sich nicht an die Kampagne von Greenpeace gegen Shell, bezüglich der geplanten -völlig sauberen und vernünftigen- Versenkung der Bohrinsel Brent Spar. Solche Verleumdungskampagnen machen auch große Unternehmen nicht gerne durch. Da heißt es sich anpassen. Und nebenbei einige Milliarden abgreifen. Wer wüßte heute z.B., daß das Alfred Wegener Institut

für Polarforschung sich mit der Erkundung des Eises in der Antarktis beschäftigt. Das wäre keine Nachricht wert. Aber wenn man dort dem Ganzen das Etikett „Klimawandel“ umhängt, dann berichtet auch „Der Spiegel“ an prominenter Stelle.

Wie kam es denn nun zu dieser Hysterie?

Seit den 50er Jahren gab es Konferenzen auf Grund von Beobachtungen die dem CO2 eine besondere Rolle in Bezug auf das Klima zu wiesen. Da sie keine bemerkenswerten Ergebnisse zeitigten wurden sie nicht besonders beachtet, vorher zugestandene Mittel gekürzt.

Die Welt hatte andere, dringlichere Sorgen. (Wie heute auch, möchte ich zufügen) Doch gegen Ende der 60er Jahre änderte sich das. Die Umweltbewegungen erhielten einen höheren Stellenwert, maßgeblich beeinflußt vom reißerischen Buch der Angestellten im US-amerikanischen Fischereiministerium Rachel Carson. “Der stumme Frühling”. Ein Buch aufwühlend und anklagend, aber voller inhaltlicher Falschaussagen und systematischer Fehler.

Im Jahre 1970 hielt die berühmte Anthroplogin Frau Prof. Margaret Mead in Bethesda einen wegweisenden Vortrag 26

„Wir stehen vor einer Periode, in der die Gesellschaft Entscheidungen im globalen Rahmen treffen muss .., Was wir von Wissenschaftlern brauchen, sind plausible, möglichst widerspruchsfreie Abschätzungen, die Politiker nutzen können, ein System künstlicher, aber wirkungsvoller Warnungen aufzubauen, Warnungen, die den Instinkten entsprechen, die Tiere vor den Hurrikan fliehen lassen„, Es geht darum, dass die notwendige Fähigkeit, Opfer zu erbringen, stimuliert wird, Es ist deswegen wichtig, unsere Aufmerksamkeit auf die Betonung großer möglicher Gefahren für die Menschheit zu konzentrieren.«

Das fiel auf fruchtbaren Boden. In den USA wurden die Mittel für die Beobachtung weltweiter Veränderung deutlich erhöht. NOAA und UNEP wurden aufgebaut. Allerdings hatte man um die Zeit noch die Sorge, die Erde könne sehr bald an einer neuen Eiszeit leiden.

In Deutschland (1971) war der Staatssekretär im Innenministerium noch unter Hans Dietrich Genscher, Dr. Günther Hartkopf, einer der ersten auf Regierungsseite, der diese von Frau Mead angesprochenen „Systeme künstlicher aber wirkungsvoller Warnungen aufzubauen“ als himmlische Möglichkeiten in der Umweltpolitik erkannt hatte. Hartkopf war später der Hauptakteur bei der Gründung des Umweltbundesamtes und bei der Gründung und Finanzierung einiger NGO´s.

Die Rolle des Dr. Hartkopf

Angeregt durch Frau Mead und ihre Idee, später befeuert durch Märchen des Buches „Die Grenzen des Wachstums“ von Dennis Meadows27 & Jay Forester und bestärkt durch die Honoratioren des Club of Rome, betrieb er effektiv und fast immer am Parlament vorbei, die Gründung und Unterstützung von Hunderten von Bürgerinitiativen und Umweltgruppen, lenkte Forschungsgelder in Institute und ihm genehme Wissenschafts-betriebe. Nach getaner Arbeit zog er 1986 stolz Bilanz wie Dr. Hug in seinem Buch „Die Angsttrompeter“ so treffend berichtet28

(Alle Fett gesetzten Texte im folgenden Zitat sind Originalzitate, der Rest – nur kursiv- ist der Text des Autors Dr. Heinz Hug):

Originalton Hartkopf: „Hohe Beamte in wichtigen Ressorts, die das Buch über die „Grenzen des Wachstums“ nicht nur gelesen, sondern auch verstanden hatten, organisierten daraufhin im Vorfeld des Treffens den Teilnehmerkreis so um, dass eine beachtliche Umweltstreitmacht den Wirtschaftsbossen gegenübergestellt wurde.“ Der argumentative Sieg der Verwaltung über die Wirtschaft und die ihr nahe stehenden Politiker war gegen Abend des denkwürdigen Tages eindeutig. Die Wirtschaft hat nie mehr versucht, ein zweites Gymnicher Gespräch zu verlangen.“ und weiter29

In Bad Kissingen offenbarte Hartkopf dem Auditorium weitere erstaunliche Details. „Die Umweltverwaltung – die ja zum weit überwiegenden Teil aus Beamten besteht – (setzt) mit langem Atem einen Großteil ihrer Vorstellungen durch, weil sie genau weiß, wann die Zeit gekommen ist, neue Grenzwerte in die politische Entscheidung einzubringen. Eine reine Staatsorganisation könnte auch nicht übermäßige Erfolge vorweisen, weil als Gegner fortschrittlichen Umweltschutzes große

finanzkräftige Wirtschaftsorganisationen mit Verbündeten innerhalb und außerhalb der Verwaltungseinheiten vorhanden sind. Zur Organisation des Umweltschutzes und damit zur Unterstützung der Umwelt bedarf es daher einer Lobby, die außerhalb von Verwaltung und Parlament Forderungen für Umweltschutz erhebt und damit in Politik und Medien gehört wird“

Nun folgt das Interessanteste. Hartkopf erklärt, wie Bürger mithilfe hoher Beamter der Ökodressur unterworfen und Bürgerinitiativen mit Steuergeldern (!) produziert wurden. Im Originalton: „Nachdem zu Beginn der eigentlichen bundesdeutschen Umweltpolitik eine solche potente Gegenseite nicht vorhanden war, musste sie geschaffen werden…

Es waren vorwiegend Beamte, die den Grundstein für die Arbeitsgemeinschaft für Umweltfragen legten und sie mit Leben und sachlichen Mitteln ausstatteten… Doch die Arbeitsgemeinschaft für Umweltfragen ist kein umweltpolitischer Kampfverband. Weil ein solcher fehlte, musste er eben gebildet werden. Es waren wiederum Beamte, die den Plan vorwärts trieben, örtliche Bürgerinitiativen zu einem Dachverband zusammenzuschließen, und die die Gründungsversammlung und noch einiges finanzierten.“ (Fast ein Staatsstreich!) Was die Beamten mit Steuergeldern aus der Taufe hoben, waren Ökosingsangvereine, wie der „Bundesverband Bürgerinitiativen Umweltschutz« (BBU), der die bürgerkriegsähnlichen Schlachten um Brokdorf und Gorleben leitete und finanzierte. Nicht zu vergessen: Auch bei der Startbahn West, wo ein Polizist von einem der „kritischen jungen Leutchen“ erschossen wurde, mischte der BBU mit. Hartkop f nennt 1986 in Bad Kissingen auch eine bemerkenswerte Zahl: „Eine Mitgliedschaft von rund vier Millionen Bürgern kann jederzeit mobilisiert werden und bildet daher ein beachtliches Potenzial, an dem die Politik nicht vorbeigehen kann.“ Das muss man sich noch einmal durch den Kopf gehen lassen. Da schaffen sich Politiker und politische Beamte mit Steuergeldern (!) eine Öko-Sturmabteilung, um auf deren Druck hin der Bevölkerung gutmenschliche Öko-Correctness und später höhere Steuern zu verordnen!

In seiner Rede geht Hartkopf auch darauf ein, wie die Ökoquisition die Medien zu nützlichen Idioten machte.

Er spricht das vornehmer aus und spricht von “ Tendenzinformationen mit denen die Zeitungsmacher besser wäre die Zeitgeistmacher gefüttert wurden„. Zur Glaubwürdigkeitssteigerung der gezielt in die Welt gesetzten Tartarenmeldungen erschienen Berichte in Wissenschaftsjournalen, die nach Hartkopf „aus der Feder von Beamten stammen, wenn man die Veröffentlichungen von Professoren und ihren beamteten Mitarbeitern an Universitäten mit einbezieht. Die Fülle der substanziellen Fachartikel

ist so groß, dass die Wirtschaft weder von der Menge noch von der Qualität her mithalten kann“. Als einzelne Bundesländer in den 70er-Jahren versuchten, überzogene Grenzwerte im Interesse des gesunden Menschenverstands und der Wirtschaft abzuschwächen, wurden sie nach Hartkopfs Aussagen

„mithilfe der Medien wegadministriert.“

Die Rolle des Journalisten Franz Alt

Und Franz Alt, bekennender CO2 Bekämpfer und Journalist sagte vor einiger Zeit zum Thema Wahrheit und Objektivität30. : „Meine Erfahrungen beschränken sich… auf die politischen Magazine. Aber natürlich gibt es hier keinen objektiven Journalismus, aber natürlich müssen wir manipulieren – im Fernsehen noch mehr als beim Rundfunk und bei der Zeitung und im Magazin noch mehr als bei der Tagesschau. Ein Journalist, der sein Tun reflektiert, wird die Subjektivität seiner Arbeit nicht bestreiten können… Diese Manipulation ist nötig und möglich. Da sich aber in einem Ordnungssystem mit freier Publizistik die intentionale Manipulation nicht ausschließen lässt, ist wesentlich, dass es einen Pluralismus der Manipulationen, Manipulationsziele und Manipulationstechniken gibt. Es gibt keine Information ohne Manipulation.“ Zitat Ende. Franz Alt ist übrigens auch derjenige, der 2004 in einer Sendung von „hart aber fair“ über die Windkraftanlagen, CO2 als Dreck bezeichnete, das es gälte zu beseitigen, z.B. mit einer Drecksteuer. Wir sind dicht dran!

Die sozialistische Internationale und die Riokonferenz von 1992

Hierbei sollte man auch nicht die Aussage des kanadischen Ölmagnaten (nach eigener Angabe auch Kommunisten! und Mao-Freundes) Maurice Strong (Generalsekretär der Rio-Konferenz 1992 unter Gro Harlem Brundtland) über die von ihm angedachte verschwörerische Gruppe der „Planetenretter“ vergessen, welche Basis für die angestrebte Global Governance31 ist. „So in order to save the planet, the group decides: Isn’t the only hope for the planet that the industrial civilizations collapse? Isn’t it our responsibility to bring that about? This group of world leaders form a secret society to bring about an economic collapse“. Und wie man offenbar richtig erkannte, läßt sich der wirtschaftliche Kollaps am besten durch Umweltschutz sowie Verkehrs-, Produktions- und Konsumbeschränkung in Kombination mit drastischer Rationierung und Verteuerung von Energie erreichen.

Zurück zu den Anfängen. Damals war ja nur das Waldsterben erfunden, DDT bereits verboten (mit vielen 100 Millionen Toten bis heute, die der Malaria seither zum Opfer fielen, eine Malaria die Ende der 70er Jahre fast ausgerottet war!) Der Atomkrieg drohte alle auszulöschen und am Wetter waren die Atombomben schuld. Das war sehr übersichtlich, der Atomwaffensperrvertrag war aber schon unterschrieben. Es galt neue Bedrohungen zu erfinden. Von Margaret Mead und anderen!

Jay Forester und Dennis Meadows sagten in „Die Grenzen des Wachstums“ das Ende der Verfügbarkeit fast aller Rohstoffe noch im letzten Jahrhundert, und u.a. Prof. Stephen Schneider sah die nahende Eiszeit voraus. Und UThant UN-Generalsekretär organisierte in Kopenhagen 1972 die erste Umweltschutzkonferenz. Dann kamen die Amerikaner auf die Idee, daß CO2 zu verdammen, um die Kernenergie zu fördern. Sie fanden einen cleveren Verbündeten in Maggie Thatcher. Günter Ederer beschreibt dies in seinem Buch “ Die Sehnsucht nach einer verlogenen Welt“ S 349 ff. (wie seherisch dieser Titel doch geradezu anmutet!) was Frau Sonja Boehmer-Christiansen in einer Forschungsarbeit über die politischen Quellen der Treibhausgashysterie

herausgefunden hat. Maggie Thatcher, als erbitterte Gegnerin der Gewerkschaften -vor allem der Bergarbeiter Gewerkschaft- bekannt, hatte andrerseits ein starkes Faible (und aus guten Gründen, wie ich anfügen möchte)

für die Kernenergie. Mit den Bergarbeiter Gewerkschaften lag sie in ständiger Fehde. Um Sellarfield -der ersten Wiederaufbereitungs-anlage in Europa- mußte sie, wegen häufiger Pannen dort, bangen. Ausgerechnet

der schon bekannte Al Gore, damals noch US-Senator, berichtete ihr von den noch nicht so bekannten CO2 Hypothesen. Sie sah ihre Chance sofort und ergriff sie: Um die Erde zu retten – a la Gore- benötigen wir Atomstrom, aber wir müssen CO2 verhindern. Denn, CO2 ist ja, nach dieser Hypothese, Haupt-Verursacher der Erwärmung, und ist gleich Verbrennung, gleich Kohle, gleich Bergarbeiter, gleich Gewerkschaft. Gedacht, getan! So überzeugten die Briten im Auftrag ihrer Premierministerin und zusammen mit den Amerikanern erst noch Australien, Kanada und Neuseeland. Dann stampften sie mit ihnen gemeinsam über die UN die erste IPCC-Konferenz aus dem Boden. Willfährige Wissenschaftler wurden mit üppigen Forschungsgeldern geködert und um das Ganze rund zu machen, durften auch Wissenschaftler aus Dritte-Welt-Staaten als Stellvertreter der Angelsachsen mitmachen32. Ähnlich war das Verhältnis bei den Amerikanern. Und, während die überwältigende Mehrheit der unabhängigen Wissenschaftler die CO2 -Hypothese ablehnt, wurde sie von den regierungsabhängigen Wissenschaftlern tatkräftig unterstützt.

Und das mit Erfolg, wie wir heute wissen.

Nur, der Schuß ging, bezüglich der Atomkraft und was unser Land betrifft, nach hinten los. Während erst die Grünen begeistert die CO2 -Hypothese aufgriffen, gefolgt von der politischen Klasse, und jetzt von der verängstigten Mehrheit im Volke, lehnten sie den 2. Teil dieses Konzepts, den Ausbau und Förderung der Kernenergie, vehement ab. Und hatten Erfolg damit. Deutschland gilt heute bei allen IPCC und sonstigen Klimakonferenzen als Scharfmacher bei gleichzeitig totaler Ablehnung der Kernkraft. Ein toller Erfolg!

Aber es kam noch besser. Nachdem die ersten IPCC Konferenzen für genügend Aufregung gesorgt hatte, schaltete sich die sozialistische Internationale ein, die ehemalige norwegischen Ministerpräsidentin Gro Harlem Brundtland war eine ihrer Vizepräsidenten. Frau Brundtland erreichte, daß die UN sie 1988 mit Leitung der Brundtland-Kommission beauftragte, welche die erste große UN-Konferenz 1992 in Rio organisieren sollte. Bei dieser Konferenz wurde das Konzept der nachhaltigen Entwicklung (sustainable development) beschossen, aus dieser ging dann die Agenda 21 hervor. Wenig danach bekannte Frau Brundtland freimütig im Interview eines kanadischem Reporter Zitat: „Das Programm der Sozialistischen Internationale ist die Basis der Riokonferenz33„. . Der Realsozialismus ist zwar tot aber es lebe die nachhaltige (grüne) Entwicklung mit „gerechter“ Zuteilung aller lebenswichtigen Ressourcen. Und jetzt ergibt das an den Eingang gestellte Zitat der britischen Außenministerin noch mehr Sinn: On Thursday, Margaret Beckett, the Foreign Secretary, compared climate sceptics to advocates of Islamic terror. Neither, she said, should have access to the media.“. Sie wird wissen warum.

Da ist nicht mehr viel hinzufügen. Nur das noch. Die Umweltbürokratie hat sich – nach Anfängen in den USA- europaweit durchgesetzt, jetzt wird die Welt in Angriff genommen. Siehe jüngstes Beispiel: Nairobi mit 6000 Delegierten aus 188 Ländern. Besser und einfacher lassen sich die Bürger gar nicht schröpfen und gängeln. Das begreifen fast alle. Auch Dritte Welt Staaten. Nur wir nicht!

Nun die letzte Frage: Können wir etwas dagegen tun? Noch ja, zum Glück: Die „verschwindende Minderheit“ der Klimaskeptiker, wie es der Spiegel im letzten Umwelttitel (Ausgabe 44) formulierte, ist sehr aktiv und wird täglich stärker und lauter. Genaueres findet man in den Veröffentlichungen der 400 (inzwischen über 2000) Wissenschaftler -einschließlich Nobelpreisträgern-), die den „Heidelberger Appell“ unterzeichnet haben, sowie der 19.000 Wissenschaftler und Fachleute, welche sich mit der so genannten „Oregon-Deklaration“ gegen das Kyoto-Protokoll gewandt haben Vielleicht demnächst Sie auch? Das gäbe doch Anlaß zur Hoffnung.

Argus im November 2006

1 Christopher Monckton im Telegraph 15.11.06http://www.telegraph.co.uk/news/main.jhtml?xml=/news/2006/11/12/nclim12.xml

2 bei seiner Eröffnungsrede in Nairobi Nov. 2006 der ganze Absatz lautete: „This is not science fiction, These are plausible scenarios, based on clear and rigorous scientific modeling. A few diehard skeptics continue trying to sow doubt. They should he seen for what they are: out of step, out of arguments and out of the time. In fact, the scientific consensus is becoming not only more complete,

but also more alarming. Many scientists long known for their caution are now saying that global warming trends are perilously close to a point of no return.“

3 Professor Dr. Helmut Kraus, emeritierter Direktor des Meteorologischen Institutes der Universität Bonn hat das Lehrbuch „Die Atmosphäre der Erde“ geschrieben (2002). Dort steht im Kapitel

„Bodennahe Klima Änderungen“ der Satz: „Am Beispiel beider Stationen (Anm.: Wien und Hohenpeißenberg) erkennt man deutlich, dass es zum Ende des 18. Jahrhunderts noch etwas wärmer war als heute”

4 Näheres hier: http://www.john-daly.com/ges/surftmp/surftemp.htm

5 Die Daten die Mann und Co unterdrückt hatten, fanden sich in seinem Computermodell, das zuletzt doch zugänglich

gemacht wurde, im Ordner „Censored Data“. Das spricht für sich.

6 Zur Güte der Vorhersagen der Computermodelle unserer Wissenschaftler vom Max Plank Institut für Meteorologie oder anderen IPCC UNO Nutznießern komme ich noch mal separat zu sprechen)

7 von Arrhenius 1890 -und viele haben sehr gute Gründe zu meinen- zu niedrig geschätzen 280 ppp

8 Bestes Beispiel für eine -sogar enge- Korrelation ist die Menge der Störche und die Menge an Babys,

die geboren werden. Diese beiden Prozesse sind eng korrelliert (wir zählen weniger Störche und haben weniger Babys), aber daß sie voneinander abhängen, das hat noch niemand ernsthaft behauptet.

9 Quelle: Fischer et al. Science Vol 283, 1999

10 Ein neues Meßverfahren – und überraschende Ergebnisse (Frederike Wagner, Universtät Utrecht)

Eine neue, robuste Technik zur Bestimmung der CO2 -Gehalte der Luft in der Vergangenheit wurde nun in den späten Neunziger Jahren eingeführt. Zwischen der Flächendichte der

Spaltöffnungen (Stomatae) in den Blättern bedecktsamiger Pflanzen (Angiospermen) und der umgebenden atmosphärischen CO2 -Konzentration besteht ein enger inverser Zusammenhang. Dieser macht es möglich, den einstigen CO2 -Gehalt der Atmosphäre aus fossilen Blättern zu bestimmen. Für weniger weit zurückliegende Epochen können CO2 -Gehalte abgeleitet werden aus Blättern, die man im Torfmoor findet.

Obwohl die Eisbohrkerne dies nicht erkennen lassen, zeigt das neue Meßverfahren, wie die atmosphärische CO2 -Konzentration von 260 ppm am Ende der letzten Eiszeit schnell auf 335 ppm im Preboreal (vor 11500 Jahren) anstieg, dann wieder auf 300 ppm abfiel und vor 9300 Jahren 365 ppm erreichte.

Diese Beobachtungen widerlegen die Annahme einer stabilen „vorindustriellen“ Atmosphäre und zeigen, daß CO2 -Niveaus wie das heutige das Ergebnis sonnengesteuerter Temperaturzunahmen mit darauffolgender Ozean-Entgasung sind. Der rekonstruierte Verlauf aus der Zeit vor 9000 Jahren

gibt Auskunft über CO2-Zunahmen von 65 ppm pro Jahrhundert, die zu CO2 -Niveaus wie dem heutigen führten, bei Temperaturen ebenfalls ähnlich den heutigen. Daraus folgt, daß man nach Beweisen für Effekte der industriellen CO2 -Emissionen vergeblich suchen wird. Weder die heutigen Temperaturen noch die heutige atmosphärische Chemie zeigen Anomalien.“ (Ende des Zitats)

11 das ist die Temperaturerhöhung, die rechnerisch bei einer Verdoppelung des CO2 Anteiles in der Luft auftritt.

12 das sind mathematische Methoden zur Herleitungen von Formeln aus aufgezeichneten Verläufen, aus denen

sich die Parameter dann bestimmen lassen

13 im Journal of Geophysical Research 104, S. 3865 (Februar 1999) unter dem Titel „Why is the global warming

proceeding much slower than expected?“

14 http://www.john-daly.com/schneidr.htm

15 zumindest mit dieser Aussage kann man wohl Wikipedia als verläßliche Wissensquelle betrachten.

Obwohl sonst viele Zweifel erlaubt sein dürfen.

16 Das haben erst kürzlich Wingham, D.J., Shepherd, A., Muir, A. und Marshall, G.J. (2006. Mass balance of the Antarctic ice sheet. Philosophical Transactions of the Royal Society

A 364: 1627-1635.) wieder festgestellt.

17 CO2 Science Magazine, 18 October 2006, In einer kürzlich durchgeführten Untersuchung über den globalen Anstieg der Meeresspiegel kommen Wissenschaftler zu der Erkenntnis: daß, wenn man dekadische

Veränderungen mittels statistischer Computeranalysen des Meerespiegels untersucht, dann erkennt man daß es keine signifikanten Anstiege von 1950 bis 2000 zu erkennen sind. Die Zahlen von 1993 bis 2000 und die Zahlen

von 1920 bis 1945 sind so gut wie gleich groß. (2,4 ± 1.0 mm/Jahr zu 2,6 ± 0,7 mm/Jahr)!

18 Kohlendioxid und Klima Vortrag vor Old Table Freiburg am 21.2.2002 von Dipl.-Phys. Alvo v. Alvensleben Revidierte Fassung März 2002, http://www.schulphysik.de/klima/alvens/klima.html

19 Zitat aus den IPCC Veröffentlichungen, gefunden bei science.orf.at/science/n#56150E

20 Viel Wissenswertes über inhaltliche und methodische Fehler und Verfälschungen der IPCC Modelle findet sich hier:www.john-daly.com/tar-20#5C5247

21 Amtliche Schätzung auf der letzten Marrakesch Klimakonferenz

22 ..(also unter Rot/Grün) auf eine kleine Anfrage zur Bennennung der Kosten von Kyoto an

23 ..so in einer Phönix-Runde zur Nairobi Konferenz am 15.11.06

24 1 % des BSP jährlich, weltweit sind das in 2005 ca.. 450 Mrd $ der Löwenanteil davon für

die EU& USA, Stern schätzt dann auch großzügig ca. 500 Mrd $

25 http://www.telegraph.co.uk/news/main.jhtml?xml=/news/2006/11/12/nclim12.xml

26 Auszüge entnommen dem Buch, „die Angsttrompeter“ von Heinz Hug:

27 Dennis Meadows gestand später ein, daß er und seine Mitarbeiter nur 0,1 Prozent ihrer Wissens auf die Datenbasis verwendeten. D.h. sie errechneten Modelle ohne jeden Bezug zur Wirklichkeit. Wie heute

wieder!

28 Alle Fett gesetzten Texte im folgenden Zitat sind Originalzitate, der Rest – nur kursiv- ist der Text des Autors Dr. Heinz Hug.

Zitat „Nein, die Hysterie ist nachweislich ein von er sozialliberalen Regierung Brandt/Schmidt veranstalteter Klamauk, der als politisches Perpetuum terribile unter Töpfer während der Ära Kohl unaufhörlich

weiterklapperte, Wie das ablief, schildert Hartkopf 1986 in Bad Kissingen. Klar und deutlich beschreibt er in einer Rede die Kriegführung der Politik gegen die Wohlstandsgesellschaft, die Industrie und deren Arbeitnehmer.

Zunächst berichtet er, wie die Vorstände großer Unternehmen am 3. Juli 1975 auf Schloss Gymnich geleimt wurden, als sie sich gegen überzogene Umweltauflagen zur Wehr setzen wollten.

29 Dr Hug:….Spiel, Satz und Sieg für die Okoquisition! Im Rückblick verwundert es nicht allzu sehr weshalb die Vorstandschefs großer Industrieunternehmen – von Ausnahmen abgesehen – sofort der

Ökofahne nacheilten und ihre leitenden Mitarbeiter die Suppe auslöffeln ließen, während die kleineren Angestellten zu Hause fleißig den Müll trennten, Dies hat Folgen, denn die allgemein akzeptierte

vollsynthetische Scheinrealität macht Unternehmen erpressbar wie der Fall der Brent Spar. Und genau aus diesem Grund haben deutsche, Firmen inclusive Shell die freie Meinung aufgegeben und sich bei der Okopolonaise eingereiht.

30 Franz Alt 1976 in einem Anfall von Ehrlichkeit in Bild der Wissenschaft

31 Zitat aus Dixy Lee Ray und Lou Guzzo (1993) „Environmental Overkill“, S.1143:

32 Die Zusammensetzung der ersten Konferenz nach Herkunftsländern zeigt das deutlich: 25 Neuseeländer, 72 Australier, 38 Kanadier, 29 Briten, 135 US Amerikaner, standen gerade mal 6 Russen, 8 Chinesen,

9 Franzosen, und 2 Indern gegenüber. Nigel Calder – der berühmte Wissenschaftsjournalist und Autor des Bestsellers von „Die launische Sonne“ kennt fast alle Teilnehmer persönlich und auch ihre Herkunft.

60 % der britischen Teilnehmer stammten aus regierungsabhängigen Organisationen, (wieviel mögen es derzeit in Nairobi sein?), nur zu 40 % waren es unabhängige Wissenschaftler.

33 Die Angsttrompeter S. 105

Posted in Energie- und Umweltpolitik | Kommentare deaktiviert für Die Klimakatastrophe – was ist wirklich dran?